BERT网络:自然语言处理的革命性突破

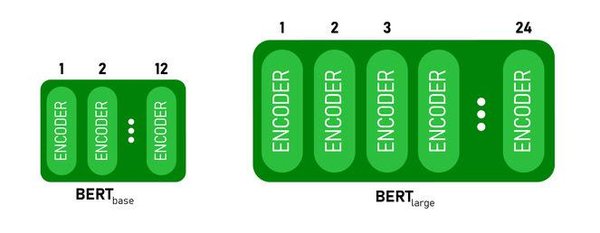

BERT(Bidirectional Encoder Representations from Transformers)网络自2018年由Google提出以来,迅速成为自然语言处理(NLP)领域的革命性技术。基于Transformer架构,BERT通过双向上下文建模,显著提升了语言理解能力,广泛应用于问答系统、文本分类、情感分析等任务。

BERT的核心原理

BERT的核心在于其双向Transformer编码器,它能够同时考虑文本的左右上下文信息。与传统单向模型相比,BERT通过掩码语言模型(Masked Language Model, MLM)和下一句预测(Next Sentence Prediction, NSP)两个预训练任务,实现了更深层次的语义理解。

1. 掩码语言模型(MLM)

MLM任务通过随机掩码部分输入词,让模型预测被掩码的词,从而学习上下文信息。这种训练方式使得BERT能够捕捉到更丰富的语义关系。

2. 下一句预测(NSP)

NSP任务则通过判断两个句子是否连续,帮助模型理解句子间的逻辑关系。这对于问答系统和文本生成任务尤为重要。

BERT的应用场景

BERT的广泛应用得益于其强大的语言理解能力。以下是一些典型的应用场景:

-

问答系统:BERT能够准确理解问题并找到相关答案,广泛应用于智能客服和知识库问答。

-

文本分类:通过BERT,文本分类任务如情感分析、垃圾邮件检测等取得了显著提升。

-

命名实体识别(NER):BERT在识别文本中的实体(如人名、地名、组织名)方面表现出色。

BERT的最新进展与优化

随着AI技术的不断发展,BERT也在不断优化和改进。最新的研究方向包括:

1. 稀疏注意力机制

稀疏注意力机制通过减少计算复杂度,提升了BERT在处理长文本时的效率。例如,NSA和MoBA等改进方法在预训练阶段引入稀疏化,显著提升了模型的训练和推理速度。

2. 多模态融合

多模态大语言模型(如LLaVA和Qwen2-VL)通过结合视觉和语言信息,进一步扩展了BERT的应用范围。这些模型在视觉问答和多模态理解任务中表现出色。

3. 硬件与算法优化

随着算力的提升,BERT的训练和推理效率得到了显著改善。硬件加速和算法优化(如FlashAttention和MoE)为BERT的广泛应用提供了技术支持。

未来展望

BERT的成功不仅在于其技术突破,更在于其推动了AI语言模型的发展。未来,随着存储压缩、多模态长序列处理等技术的进步,BERT及其衍生模型将在更多领域展现其潜力,助力AGI(通用人工智能)的实现。

结语

BERT网络作为自然语言处理领域的里程碑,其影响深远。通过不断的技术创新和优化,BERT及其衍生模型将继续推动AI技术的发展,为人类带来更多智能化解决方案。无论是学术研究还是工业应用,BERT都将是不可或缺的重要工具。

通过本文的探讨,希望读者能够更深入地理解BERT网络的核心原理及其应用,为未来的AI研究和实践提供有力支持。