Transformer模型的诞生与重要性

2017年,Transformer模型的推出标志着自然语言处理(NLP)领域的一次重大突破。这一模型摒弃了传统的循环神经网络(RNN)和卷积神经网络(CNN),转而采用自注意力机制(Self-Attention Mechanism),极大地提升了模型处理长距离依赖关系的能力。Transformer的出现不仅为NLP领域带来了革命性的变化,也为计算机视觉(CV)等其他领域提供了新的思路。

Transformer在自然语言处理中的应用

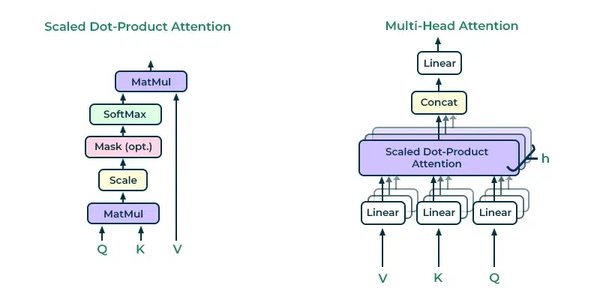

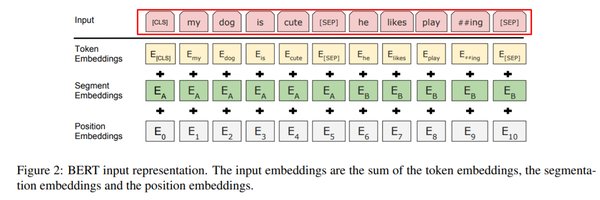

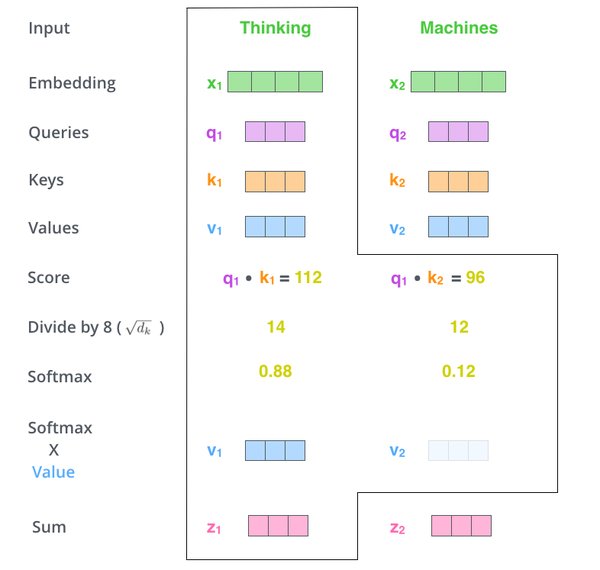

Transformer模型的核心在于其自注意力机制,这一机制使得模型能够同时处理输入序列中的所有元素,从而捕捉到更丰富的上下文信息。在NLP领域,Transformer被广泛应用于机器翻译、文本生成、情感分析等任务。例如,BERT、GPT等基于Transformer的预训练模型在多项NLP任务中取得了显著的成绩,推动了NLP技术的快速发展。

Transformer在计算机视觉中的应用

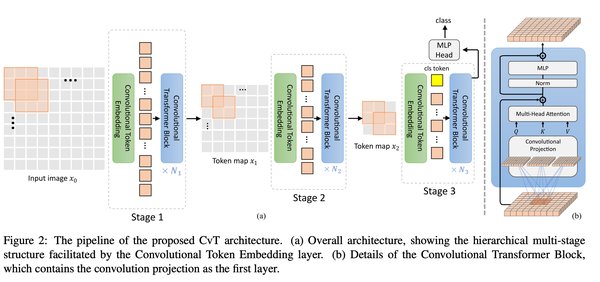

尽管Transformer最初是为NLP设计的,但其在计算机视觉领域的应用也取得了令人瞩目的成果。Vision Transformer(ViT)将Transformer模型应用于图像分类任务,通过将图像分割成小块并视为序列输入,ViT在多个图像分类基准数据集上达到了与CNN相当甚至更好的性能。这一成功表明,Transformer模型具有跨领域的通用性,为CV领域带来了新的研究方向。

通用人工智能(AGI)的未来展望

Transformer模型的成功不仅限于特定任务,其强大的泛化能力为通用人工智能(AGI)的发展提供了重要支持。2024年9月,ChatGPT公司发布的最新大型语言模型o1,展示了全新水平的AI能力。这一模型不仅在自然语言理解和生成方面表现出色,还在多模态任务中展现了强大的能力,开启了AGI的创新步伐。未来,随着Transformer模型的不断优化和应用,AGI的实现将不再遥不可及。

结语

Transformer模型作为深度学习技术的重要支柱,已经在自然语言处理和计算机视觉领域取得了显著成就。其自注意力机制和跨领域应用能力,为人工智能的发展提供了新的动力。随着技术的不断进步,Transformer模型将继续推动AGI的实现,为人类社会带来更多的创新和变革。