2024年2月24日,中国人工智能领军企业深度求索(DeepSeek)在“开源周”期间发布了首个开源项目——FlashMLA。这一项目不仅展现了国产AI在底层技术上的突破性实力,更以其高效、低成本的特点,赢得了全球开源社区的广泛赞誉。

FlashMLA的技术亮点

FlashMLA是专为英伟达Hopper架构GPU设计的高效MLA(多头潜注意力)解码内核,针对可变长度序列服务进行了优化。其核心优势在于:

-

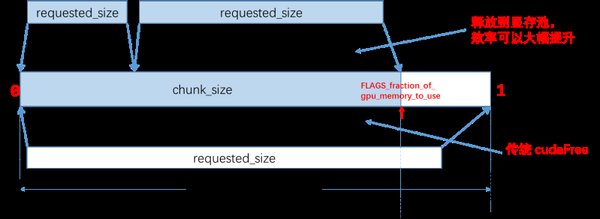

显存优化:通过独特的算法设计,FlashMLA大幅减少了KV(键值)矩阵的重复计算,从而降低了显存消耗,解决了AI推理过程中显存容量不足的瓶颈问题。

-

计算效率:在H800 GPU上,FlashMLA实现了每秒处理3000GB数据、每秒执行580万亿次浮点运算的高性能表现。

-

应用广泛:适用于长序列处理、实时应用(如聊天机器人、虚拟助手)以及边缘设备部署,显著提升了资源利用率和推理速度。

开源社区的积极反响

深度求索的开源举措不仅展示了其技术实力,更驳斥了外界对其虚报成本的质疑。美国旧金山AI行业解决方案提供商龙鳞工业公司的首席技术官斯蒂芬·皮门特尔在社交平台X上表示,深度求索的开源项目“有力驳斥了外界常说的‘他们在训练程序上撒谎’的论调”。开源开发者纷纷称赞深度求索“正再次拓展AI基础设施的极限”。

对AI行业的深远影响

FlashMLA的开源不仅为AI公司、学术机构和企业用户带来了更低的成本和更快的推理速度,还为国产算力芯片的推广提供了技术支持。沐曦技术团队在FlashMLA开源后迅速响应,仅用2小时即完成与沐曦GPU的适配工作,并将其代码提交至开源社区。这一创新技术有望推动“推理平价”,降低推理成本,进一步推动国产算力芯片在推理领域的应用。

结语

深度求索通过FlashMLA等开源项目,展示了国产AI技术在低成本、高性能领域的突破性进展。这不仅是一次技术展示,更是中国AI企业向世界发出的开放宣言——通过共享底层技术,加速人工智能惠及全人类的进程。FlashMLA的成功,标志着国产AI技术在全球AI社区中的重要地位,也为未来AI技术的发展开辟了新的道路。