RLHF与RLAIF:新一代AI训练方法

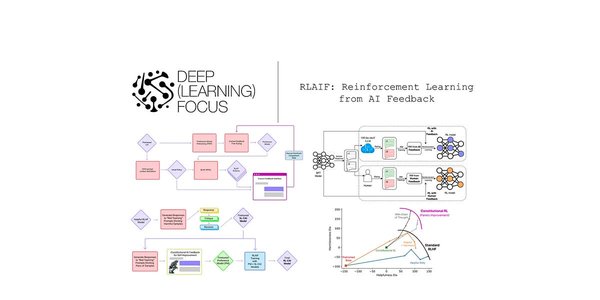

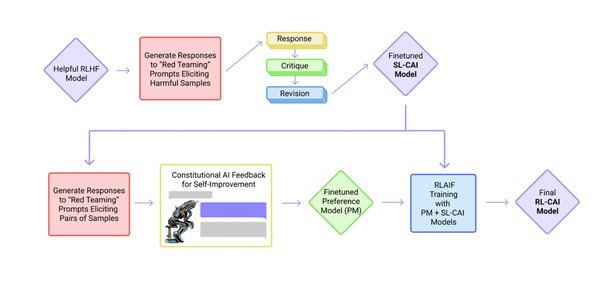

在人工智能研究领域,强化学习与人类反馈(RLHF)和强化学习与人工智能反馈(RLAIF)正逐渐成为训练大型语言模型(LLM)的核心方法。这些方法不仅能够提升模型的性能,还能在复杂的任务中展现出卓越的推理能力。本文将深入探讨RLHF和RLAIF的最新研究进展,特别是在迷宫导航和多语言优化中的应用。

迷宫导航中的RLHF应用

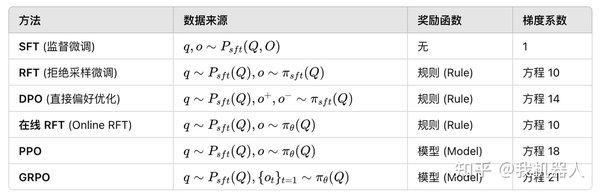

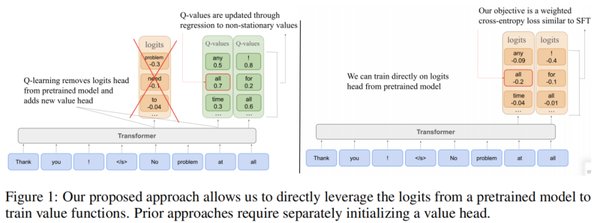

在迷宫导航任务中,研究者们提出了一种两阶段的训练框架。首先,通过监督微调(SFT)使LLM具备基于视觉迷宫输入预测移动指令的基础能力。随后,采用群体相对策略优化(GRPO)来进一步优化模型的视觉推理过程。这一方法借鉴了DeepSeek-R1的强化学习策略,通过精心设计的奖励函数,成功激发了模型在迷宫导航中的推理行为。

关键步骤:

-

监督微调(SFT):训练模型预测移动指令。

-

群体相对策略优化(GRPO):优化视觉推理过程。

多语言优化中的RLHF挑战

在多语言处理中,RLHF同样面临挑战。以GPT-2的tokenizer为例,其对英语的优化导致其他语言在编码时所需的token数量显著增加。例如,缅甸的Shan语言在编码时所需的token数量是英语的15倍,而葡萄牙语和德语也分别比英语多出50%的token。这一现象凸显了在多语言环境中优化RLHF策略的重要性。

多语言优化问题:

-

英语优化tokenizer:对其他语言不友好。

-

token数量差异:Shan语言为英语的15倍,葡萄牙语和德语为英语的1.5倍。

RLHF与RLAIF的未来展望

随着RLHF和RLAIF技术的不断发展,其在复杂任务中的应用潜力愈发显著。研究者们正在探索新的RL算法、数据收集方法和奖励训练算法,以进一步提升模型的性能。同时,复现O1等经典实验也变得更加简便,只需随机选择基础模型、SFT数据集和超参,以及随机RL算法和超参,即可完成preprint。

未来研究方向:

-

新RL算法的开发:提升模型在复杂任务中的表现。

-

数据收集与奖励训练:优化训练过程,提高模型效率。

通过不断优化RLHF和RLAIF方法,我们有望在更多领域实现AI模型的突破,为未来的智能应用奠定坚实基础。