GNN层的灵活性与创新

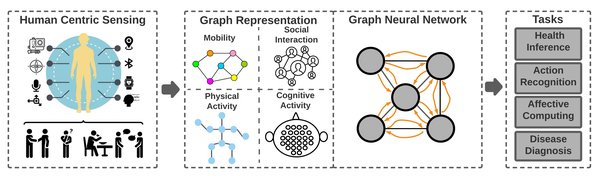

图神经网络(GNN)作为深度学习领域的重要分支,在处理复杂图形数据时展现出了强大的能力。GNN层的设计与实现是GNN模型的核心,直接影响模型的性能和扩展性。本文将深入探讨GNN层的灵活性与创新,重点介绍如何通过分离GNN层与模型架构实现代码灵活性,并支持持续集成新的架构、GNN层或池化层。

GNN与GCN的差异

GNN与图卷积神经网络(GCN)在处理图形数据上有许多相似之处,但它们之间仍然存在一些关键差异:

-

模型结构:GNN通常包含多个图卷积层,每个图卷积层都会更新节点的特征,而GCN只有一个或多个图卷积层。因此,GCN通常比GNN更简单,计算效率更高。

-

参数共享:在GCN中,同一层的所有节点共享相同的权重,而在GNN中,每个节点都有自己的权重。这意味着GCN更易于训练和优化,而GNN在处理大型图形时可能会遇到参数爆炸的问题。

-

传播机制:GNN使用的是基于邻居聚合的传播机制,它将节点的特征聚合为其邻居的特征。而GCN使用的是基于图的传播机制,它将节点的特征更新为其自身的特征和其邻居的特征的加权和。

代码灵活性:分离GNN层与模型架构

通过分离GNN层与模型架构,可以实现出色的代码灵活性,允许用户无缝替换不同类型的层作为超参数。以下是一个简单的Python代码示例,展示了如何使用PyTorch Geometric库构建GCN模型:

“`python

import torch

from torch_geometric.nn import GCNConv

from torch_geometric.data import Data

class GCN(torch.nn.Module):

def __init__(self, in_channels, hidden_channels, out_channels):

super(GCN, self).__init__()

self.conv1 = GCNConv(in_channels, hidden_channels)

self.conv2 = GCNConv(hidden_channels, out_channels)

self.act = torch.nn.ReLU()

def forward(self, data):

x, edge_index = data.x, data.edge_index

x = self.conv1(x, edge_index)

x = self.act(x)

x = self.conv2(x, edge_index)

x = self.act(x)

return x

“`

在这个示例中,我们定义了一个名为GCN的类,它继承了torch.nn.Module基类。这个类包含两个GCN卷积层和一个ReLU激活函数。通过这种方式,用户可以轻松替换不同类型的GNN层,实现模型的灵活性和可扩展性。

前沿技术:RevGNN-Deep与RevGNN-Wide

为了提高GNN的可扩展性,研究人员提出了RevGNN-Deep和RevGNN-Wide等前沿技术。这些模型通过可逆连接、群卷积、权重捆绑和平衡模型等技术,显著提高了记忆和参数效率。例如,RevGNN-Deep(1001层,每层80个通道)和RevGNN-Wide(448层,每层224个通道)在ogbn-蛋白质数据集上分别获得了87.74±0.13和88.14±0.15的ROC-AUC。据我们所知,RevGNN-Deep是文献中最深的一个数量级的GNN。

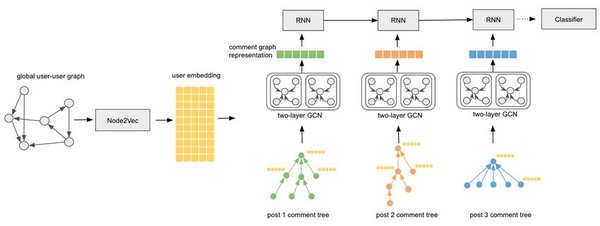

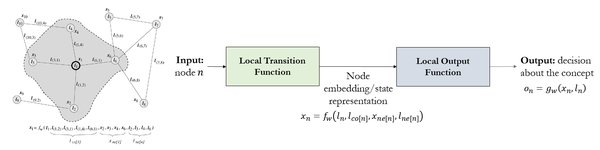

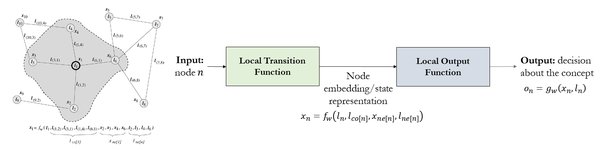

复杂GNN层的汇聚操作

复杂GNN层的汇聚操作与简单GNN层有所不同。简单GNN(单层GNN)只考虑节点的上一时刻的嵌入,再通过MLP操作得到现在时刻的新嵌入。然而,复杂GNN的汇聚操作为了考虑图的关联性,会在其每一层使用”pooling operation”,如Vn+1=Pooling(Vn, Vn的邻居节点, Vn的邻边),以此更新节点的向量。这种操作使得复杂GNN在处理复杂图形数据时更具优势。

结论

GNN层的灵活性与创新是推动图神经网络发展的重要动力。通过分离GNN层与模型架构,可以实现代码灵活性,并支持持续集成新的架构、GNN层或池化层。此外,前沿技术如RevGNN-Deep和RevGNN-Wide展示了GNN层在实际应用中的巨大潜力。未来,随着技术的不断进步,GNN层将在更多领域发挥重要作用。