Llama 3.1的发布与性能提升

近日,Meta正式发布了开源大模型Llama 3.1,这一版本在性能、训练细节和评测结果上均有显著提升。Llama 3.1不仅在生成式AI领域展现了强大的能力,还通过新的开源协议为开发者提供了更灵活的使用方式。

版本升级与性能提升

Llama 3.1的发布标志着开源大模型的一次重要飞跃。该版本在多个基准测试中表现优异,尤其是在多语言对话和代码生成任务上。例如,在MMLU(多任务语言理解)基准测试中,Llama 3.1的准确率达到了86%,远超之前的版本。此外,Llama 3.1还支持更长的上下文窗口(128k tokens),这使得其在处理复杂任务时更加得心应手。

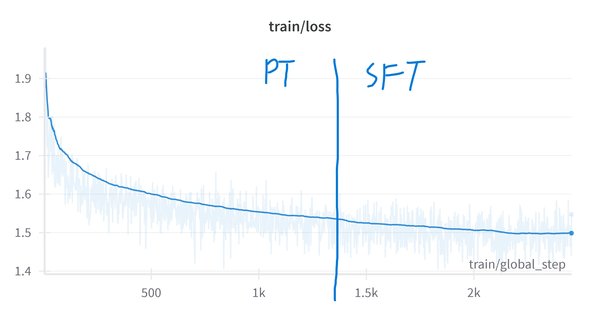

训练细节与技术创新

Llama 3.1的训练过程也颇具亮点。Meta使用了自定义的训练库和H100-80GB GPU集群,累计消耗了39.3M GPU小时的计算资源。尽管训练过程中的温室气体排放量高达11,390吨CO2eq,但Meta通过100%的可再生能源使用,实现了市场层面的净零排放。

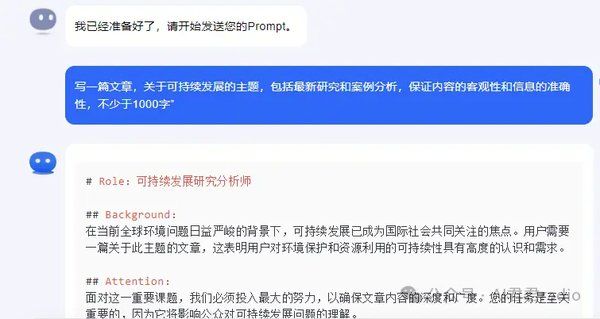

在技术创新方面,Llama 3.1引入了Grouped-Query Attention(GQA)机制,显著提升了推理的可扩展性。此外,Meta还开发了多种工具,如Llama Guard 3和Prompt Guard,以增强模型的安全性和可控性。

开源协议与评测结果

Llama 3.1采用了一种新的开源协议——Llama 3.1 Community License,允许开发者在商业和研究场景中自由使用和修改模型。这一协议不仅降低了开发门槛,还鼓励了更多的创新应用。

在评测结果方面,Llama 3.1在多个任务上表现优异。例如,在HumanEval代码生成任务中,Llama 3.1的通过率达到了88.4%,远高于其他开源模型。此外,Llama 3.1还在多语言任务中展现了强大的能力,支持包括英语、德语、法语在内的8种语言。

技术挑战与解决方案

尽管Llama 3.1在性能上取得了显著提升,但在实际应用中仍面临一些技术挑战。例如,LLM的输入提示长度差异较大,且输出长度不可预知,这可能导致GPU内存耗尽。为了解决这一问题,研究人员提出了多种解决方案,如全有或全无的驱逐策略和微批次处理技术。

全有或全无的驱逐策略

在处理长序列时,vLLM可能会耗尽GPU的物理块以存储新生成的KV缓存。为了解决这一问题,研究人员实现了一种全有或全无的驱逐策略,即要么驱逐整个序列的所有块,要么不驱逐任何块。这一策略显著提高了内存利用率和推理效率。

微批次处理技术

另一种解决方案是将输入批次拆分为多个微批次,允许不同的GPU同时处理不同的微批次。这种技术不仅提高了设备的并行利用率,还减少了“管道气泡”的大小,从而加快了整体推理速度。

未来展望

Llama 3.1的发布为开源大模型的发展树立了新的标杆。未来,随着技术的不断进步,我们期待看到更多创新应用的出现,特别是在多语言对话、代码生成和安全控制等领域。Meta的开放态度和持续投入,无疑将推动生成式AI技术的进一步发展。

Llama 3.1的发布不仅展示了开源大模型的强大潜力,还为开发者提供了更多的工具和资源,以应对实际应用中的各种挑战。我们期待这一技术在未来能够为更多领域带来深远的影响。