Transformer 架构的诞生与影响

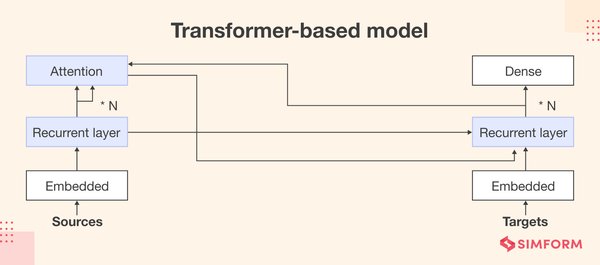

2017 年,谷歌团队在论文《Attention is All You Need》中首次提出了 Transformer 架构,这一技术迅速成为自然语言处理领域的基石。前谷歌 AI 研究员雅各布・乌斯克尔特在 TED AI 大会上回顾了这一历程,并强调了 Transformer 对现代生成式人工智能模型的深远影响。

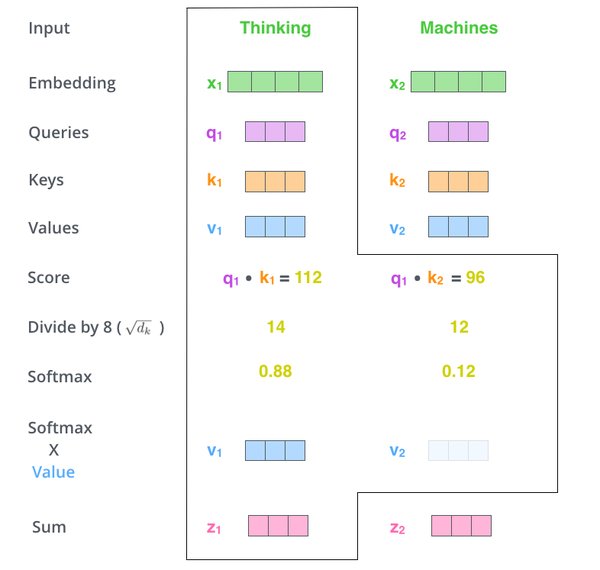

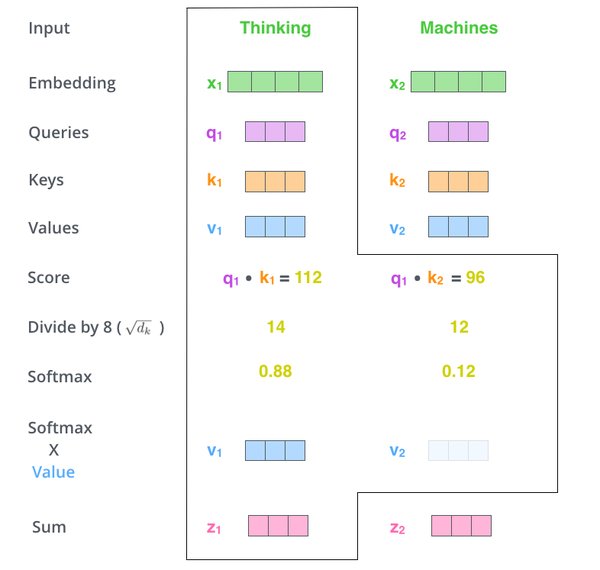

尽管团队对 Transformer 的潜力寄予厚望,但乌斯克尔特坦言,他们并未完全预见到它在 ChatGPT 等产品中的关键作用。Transformer 的核心机制——自注意力机制(Self-Attention),使得模型能够更高效地处理长序列数据,从而在语言理解、文本生成等任务中表现出色。

Transformer 在生成式 AI 中的应用

Transformer 架构的引入,彻底改变了生成式人工智能的发展轨迹。以下是其关键应用领域:

– 语言模型:如 GPT 系列,利用 Transformer 生成高质量文本。

– 图像生成:如扩散模型(Diffusion Models),结合 Transformer 实现更精准的图像生成。

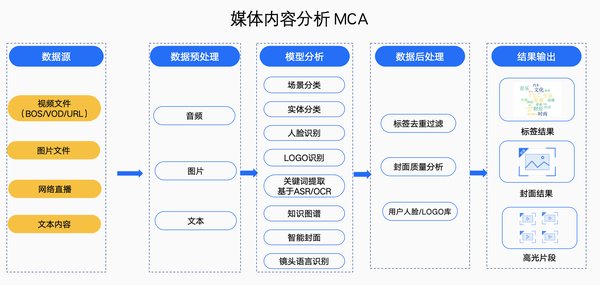

– 多模态学习:如 CLIP,将文本与图像结合,实现跨模态理解。

然而,生成式 AI 也面临挑战。例如,训练数据中的采样偏差可能导致模型输出带有偏见的结果。2017 年,普林斯顿大学的研究发现,AI 模型倾向于将欧洲名字与“愉悦”关联,而将“女性”与艺术而非科学关联。

从 AI 到生物化学:乌斯克尔特的新征程

离开谷歌后,乌斯克尔特创办了 Inceptive 公司,致力于将深度学习技术引入生物化学领域。他将其称为“生物软件”,旨在设计更高效的药物。

Inceptive 的核心技术包括:

– 蛋白质设计:利用深度学习预测蛋白质结构,加速药物开发。

– 基因编辑:通过 AI 优化 CRISPR 技术,提高精准度。

– 生物信息学:分析大规模生物数据,发现新的治疗靶点。

乌斯克尔特认为,AI 在生物化学领域的潜力不亚于其在语言和图像生成中的成就。

未来展望

Transformer 架构的崛起,标志着 AI 技术进入了一个新的时代。从语言模型到生物软件,其应用范围不断扩大。然而,随着技术的进步,我们也需要关注其伦理和社会影响,确保 AI 的发展与人类价值观保持一致。

乌斯克尔特的故事,不仅是对 Transformer 技术的回顾,更是对 AI 未来可能性的探索。正如他所言:“我们只是刚刚开始。”