引言

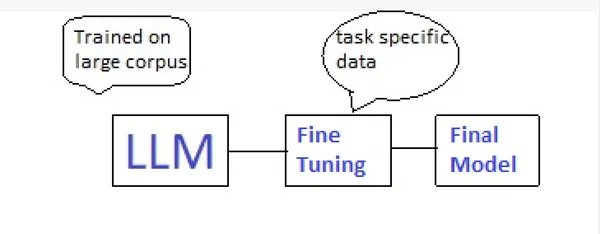

随着人工智能技术的飞速发展,大模型(LLM)在各个领域的应用日益广泛。然而,如何高效地微调这些庞然大物,使其适应特定任务,一直是业界关注的焦点。Q-Lora技术,作为低秩适应(LoRA)和量化技术的结合,为大模型微调提供了新的解决方案。

Q-Lora技术解析

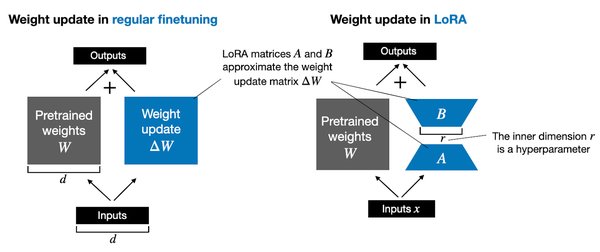

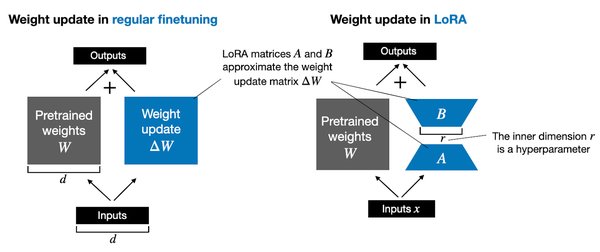

低秩适应(LoRA)

低秩适应是一种通过引入低秩矩阵来微调大模型的方法。它通过减少参数数量,降低了计算成本,同时保持了模型的性能。

量化技术

量化技术通过将模型的权重和激活值从浮点数转换为低精度的整数,进一步减少了模型的存储和计算需求。

Q-Lora的结合

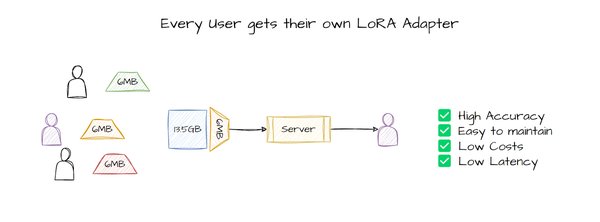

Q-Lora将低秩适应和量化技术结合,不仅减少了参数数量,还通过量化进一步压缩了模型,实现了更高效的微调。

Q-Lora的应用案例

金融领域

在金融领域,Q-Lora技术可以用于微调大模型,使其更好地理解金融术语和市场动态,从而提供更精准的投资建议。

医疗领域

在医疗领域,Q-Lora技术可以帮助大模型快速适应新的医疗知识,提高诊断的准确性和效率。

Q-Lora的未来展望

技术优化

随着研究的深入,Q-Lora技术有望在保持性能的同时,进一步降低计算和存储成本。

应用扩展

Q-Lora技术有望在更多领域得到应用,如教育、法律等,为各行各业带来智能化升级。

结论

Q-Lora技术为大模型微调提供了新的思路,通过低秩适应和量化技术的结合,实现了更高效的模型微调。随着技术的不断优化和应用领域的扩展,Q-Lora有望成为AI大模型微调的重要工具。

参考文献

- 网页1:公元1943年,麦卡洛克与皮茨在芝加哥大学密室中绘制出”神经网络符篆”,点燃了硅基文明的第一缕火种。

- 网页2:DeepSeek 位列全球 AI 应用榜第二,其凭借 1 月开源自家 DeepSeek-R1 模型,在全球引起巨大热议。

- 网页3:Krea 将 R1 集成到产品中,还有另一个前提条件——成本。在考验自然语言推理的 Zebra Logic 测试中,DeepSeek-R1 评分虽不如 OpenAI-o1,但评分却比其他非推理模型高很多。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...