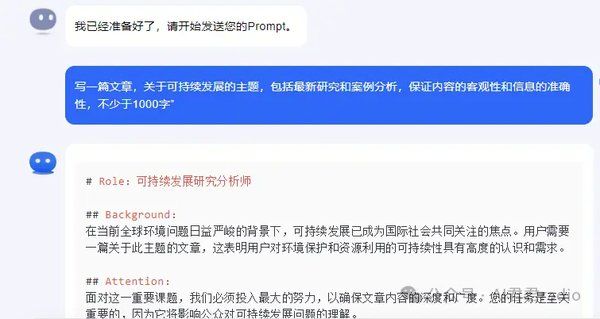

引言

随着生成式AI模型的快速发展,传统的CPU和GPU在处理大规模语言模型(LLM)时,逐渐暴露出计算密度和内存带宽的瓶颈。Groq公司推出的LPU™推理引擎和GroqChip™处理器,正是为了解决这一问题而生。本文将深入探讨GroqChip™的技术优势及其在AI硬件领域的革命性意义。

传统硬件的瓶颈

在AI语言模型的应用中,推理速度是关键指标之一。传统的CPU和GPU虽然在通用计算任务中表现出色,但在处理高度并行的深度学习模型时,往往面临以下挑战:

– 计算密度不足:传统硬件无法高效处理大规模矩阵运算。

– 内存带宽限制:数据传输速度成为性能提升的瓶颈。

– 延迟问题:每个单词的计算时间较长,导致文本生成速度受限。

LPU™推理引擎的创新

Groq的LPU™推理引擎通过以下技术突破,显著提升了AI语言模型的推理速度:

1. 端到端处理单元:LPU™专为AI语言模型设计,优化了计算和内存访问模式。

2. 内存带宽优化:通过创新的架构设计,减少了数据传输的延迟。

3. 高效计算能力:LPU™在单位时间内能够处理更多的计算任务,从而加速文本生成。

GroqChip™处理器的技术优势

作为LPU™推理引擎的核心,GroqChip™处理器在以下方面展现了其独特优势:

– 高性能计算:支持大规模并行计算,显著提升推理速度。

– 兼容性:支持标准的机器学习框架,如PyTorch、TensorFlow和ONNX。

– 开发支持:提供GroqWare™套件,帮助开发者优化工作负载并开发自定义应用程序。

AI硬件领域的未来趋势

GroqChip™处理器的推出,标志着AI硬件领域的一次重要革新。随着生成式AI模型的规模不断扩大,对高性能计算和内存带宽的需求也将持续增长。未来,AI加速器(如NPU和DLP)将成为行业的主流选择,而GroqChip™无疑在这一趋势中占据了领先地位。

结语

GroqChip™处理器和LPU™推理引擎的推出,不仅解决了传统硬件在AI语言模型中的瓶颈问题,还为生成式AI应用的发展提供了强大的技术支撑。对于企业和开发者而言,这一创新将极大地提升AI应用的效率和性能,推动AI技术的进一步普及。