大语言模型(LLM)作为人工智能领域的核心技术之一,近年来在自然语言处理任务中展现了卓越的能力。然而,随着应用的深入,LLM的技术局限性和挑战也逐渐显现。本文将从长期记忆、定制化模型开发、技术挑战等方面,探讨LLM的技术革新与未来发展方向。

长期记忆:LLM的新突破

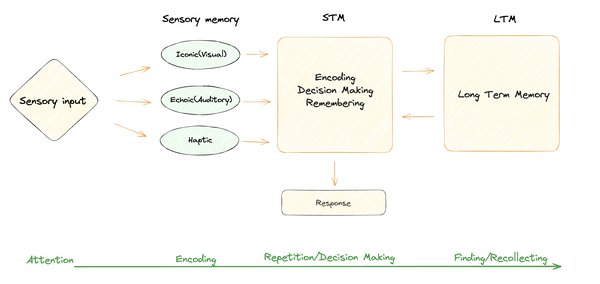

长期以来,LLM在处理长上下文信息时面临显著挑战,主要受限于其“上下文窗口”的容量。OpenAI与SoftBank合作开发的“Crystal Intelligence”项目,正是为了解决这一问题。该项目通过引入“长期记忆”技术,使LLM能够在推理过程中持续学习和记忆信息,从而提升其回答精度和应用范围。Google的研究团队也提出了“Titans”模型,通过添加“记忆”模块,实现了对长上下文信息的有效处理。这些技术的突破,为LLM在复杂任务中的应用铺平了道路。

定制化模型:满足业务需求的关键

LLM的通用性虽然强大,但在特定业务场景中,其表现往往不尽如人意。为了解决这一问题,许多企业开始开发定制化LLM。例如,日本みずほフィナンシャルグループ与NTT数据合作,开发了专用于金融业务的LLM。该模型基于NTT的“tsuzumi”模型,通过追加学习企业财务数据、行业研究报告等专有信息,显著提升了其在金融领域的表现。

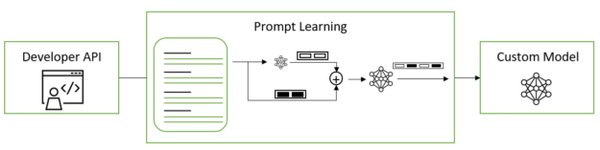

定制化LLM的开发策略主要包括以下两种:

-

冻结模型参数:通过上下文学习或提示工程(Prompt Engineering)调整模型行为,成本较低。

-

更新模型参数:通过微调(Fine-Tuning)或强化学习从人类反馈(RLHF)等方法,对模型进行深度优化。

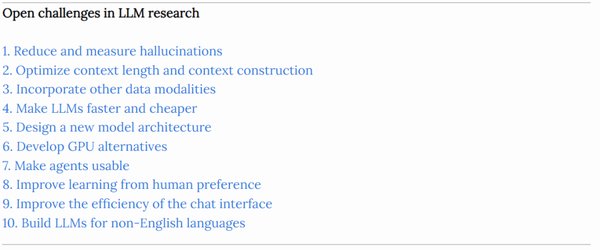

LLM的技术挑战

尽管LLM在技术上取得了显著进展,但其仍面临诸多挑战:

-

上下文窗口限制:现有的LLM在处理长文本时,往往因上下文窗口容量不足而导致信息丢失。

-

计算资源消耗:LLM的训练和推理需要大量计算资源,尤其在大规模模型上,成本极高。

-

语言处理效率:LLM在处理低频率语言或拼写错误时,往往表现不佳,导致计算成本增加和精度下降。

未来展望

未来,LLM的发展将集中在以下几个方面:

-

长期记忆技术的优化:通过更高效的记忆模块设计,提升LLM的长上下文处理能力。

-

定制化模型的普及:随着企业需求的增加,定制化LLM将成为主流,推动AI在各行业的深度应用。

-

计算效率的提升:通过技术创新,降低LLM的训练和推理成本,使其更具普适性。

LLM的技术革新将继续推动人工智能领域的发展,其在长期记忆、定制化模型和计算效率等方面的突破,将为未来的AI应用开辟更广阔的前景。