开源视频生成模型的崛起

2024年,开源视频生成模型迎来了前所未有的发展。2月25日晚,阿里云宣布开源其视觉生成基座模型万相2.1(Wan),采用最宽松的Apache2.0协议,支持14B和1.3B两个参数规格,涵盖文生视频和图生视频任务。在权威评测集VBench中,万相2.1以总分86.22%的成绩超越Sora、Luma、Pika等国内外模型,位居榜首。这一成就不仅展示了阿里云在视频生成领域的领先地位,也标志着开源视频生成模型的崛起。

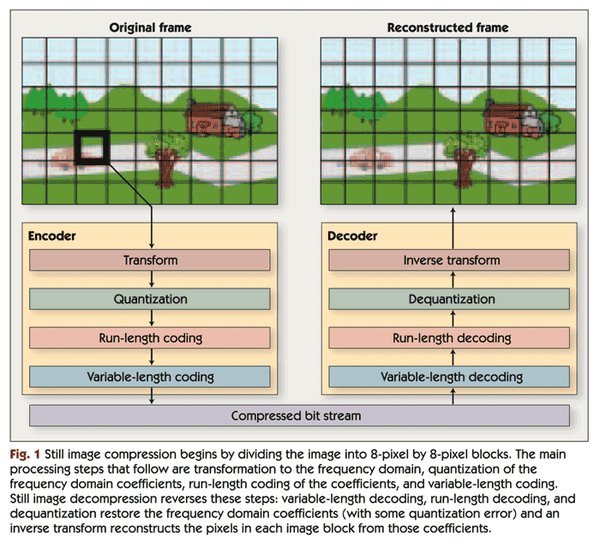

万相2.1的技术突破

万相2.1在算法设计上基于主流DiT架构和线性噪声轨迹Flow Matching范式,研发了高效的因果3D VAE、可扩展的预训练策略等。该模型能够实现无限长1080P视频的高效编解码,并通过将空间降采样压缩提前,在不损失性能的情况下进一步减少了29%的推理时内存占用。此外,1.3B版本能在消费级显卡运行,仅需8.2GB显存即可生成高质量视频,适用于二次模型开发和学术研究。

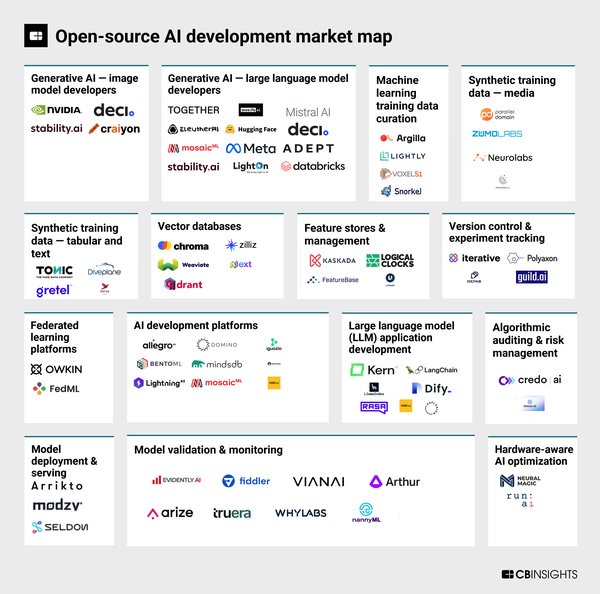

开源潮席卷行业

由DeepSeek引发的开源热正在席卷行业。自2月24日起,DeepSeek接连开源5天5个代码库,涉及GPU使用场景的效率优化、用于MoE模型训练和推理的开源EP通信库等。在DeepSeek的推动下,昆仑万维开源了其旗下面向AI短剧创作的视频生成模型SkyReels-V1和表情动作可控算法SkyReels-A1。SkyReels-V1支持33种细腻人物表情与400+种自然动作组合,高度还原真人情感表达;SkyReels-A1则支持视频驱动的电影级表情捕捉,实现高保真微表情还原。

多模态大模型的未来

随着万相2.1的开源,阿里云实现了全模态、全尺寸大模型的开源,目前通义大模型的衍生模型数量已超过10万个,成为全球最大的开源模型。微软也宣布开源多模态智能体Magma,具备跨数字、物理世界的多模态能力,能自动处理图像、视频、文本等不同类型数据,还能够推测视频中人物或物体的意图和未来行为。Magma与具身智能的协同效应展示了多模态大模型在未来的广泛应用前景。

结语

开源视频生成模型的崛起不仅推动了AI大模型在多模态领域的创新与突破,也为影视创作、动画设计、广告设计等领域带来了新的可能性。随着更多厂商加入开源行列,AI大模型的未来将更加多元化和智能化。