移动端轻量化神经网络的发展背景

随着移动设备的普及和计算能力的提升,轻量化神经网络在移动端的应用成为研究热点。传统的深度学习模型往往需要大量的计算资源和存储空间,难以在移动设备上高效运行。为了解决这一问题,研究人员提出了多种轻量化神经网络架构,其中SqueezeNet和MobileOne是典型代表。

SqueezeNet:轻量化神经网络的先驱

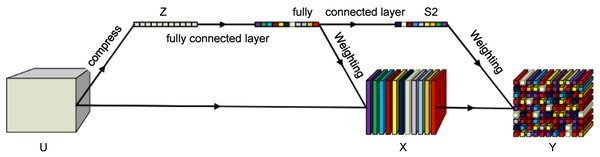

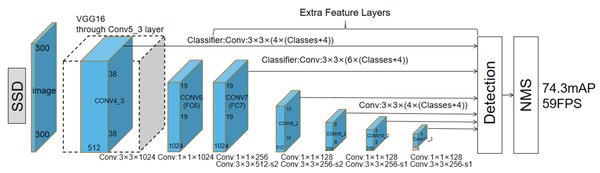

SqueezeNet是早期轻量化神经网络的代表之一,通过减少模型参数和计算量,在保持较高识别精度的同时,显著降低了模型大小。SqueezeNet的核心思想是使用1×1卷积核替代部分3×3卷积核,从而减少参数数量。此外,SqueezeNet还引入了“Fire模块”,通过压缩和扩展操作进一步优化模型结构。

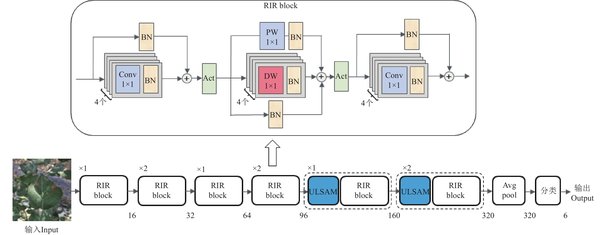

MobileOne:苹果研究团队的新突破

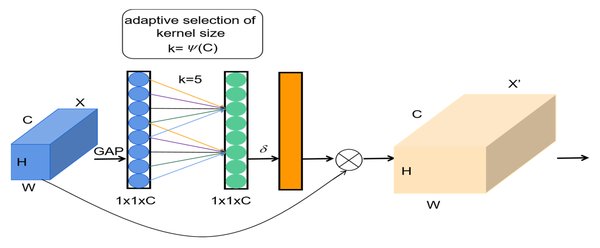

苹果研究团队基于iPhone 12平台开发的MobileOne神经网络架构,在ImageNet数据集上实现了低于1毫秒的推理时延和75.9%的识别精度。MobileOne通过以下策略提升模型推理效率:

-

低秩分解:利用奇异值分解(SVD)技术,将大矩阵分解为较小矩阵,从而减少模型参数和存储需求。

-

并行计算:采用流水线执行框架,使数据在各阶段无缝流动,提升计算效率。

-

动态调整:根据数据到达顺序和标签变化,动态调整模型训练和推理过程,以适应移动端数据的非平稳性。

提升模型推理效率的关键技术

在移动端轻量化神经网络的研究中,提升模型推理效率的关键技术包括:

-

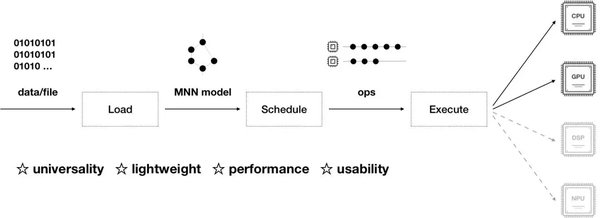

数据流优化:确保数据在模型各阶段高效流动,减少等待时间和计算瓶颈。

-

模型压缩:通过低秩分解、剪枝和量化等技术,减少模型参数和计算量。

-

硬件加速:利用移动设备的GPU和NPU等硬件加速单元,提升模型推理速度。

结论

从SqueezeNet到MobileOne,移动端轻量化神经网络的发展历程展示了模型优化和推理效率提升的多种策略。苹果研究团队的MobileOne架构在ImageNet数据集上的优异表现,为移动端AI应用提供了新的解决方案。未来,随着硬件和算法的进一步优化,轻量化神经网络将在移动端发挥更大的作用。