在人工智能(AI)和机器学习(ML)领域,高性能计算芯片的需求日益增长。Cerebras Systems和NVIDIA作为这一领域的领军企业,分别推出了WSE-3和H100两款顶尖芯片。本文将深入探讨这两款芯片的性能差异及其对AI计算的影响。

架构与制造工艺

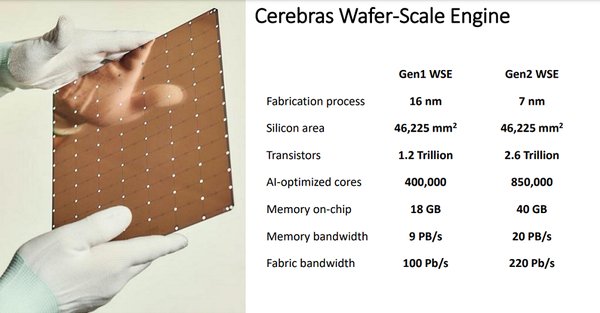

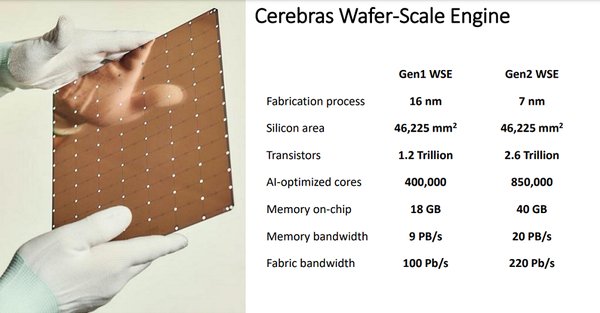

Cerebras WSE-3采用了台积电5nm工艺,拥有超过4万亿个晶体管,芯片面积达到46225mm²,是世界上最大的AI芯片。相比之下,NVIDIA H100虽然也采用了先进的制造工艺,但其芯片面积和晶体管数量远不及WSE-3。Cerebras的创新之处在于其“晶圆级引擎”设计,即将整个晶圆作为单一芯片使用,从而减少了芯片间的互连和网络成本。

内存与计算能力

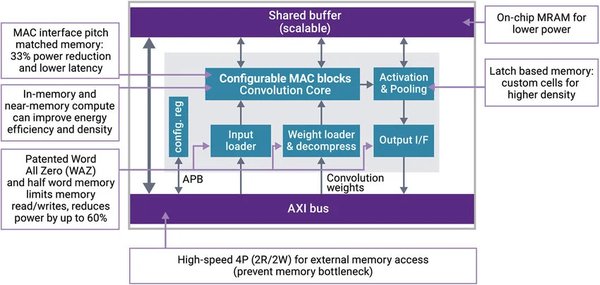

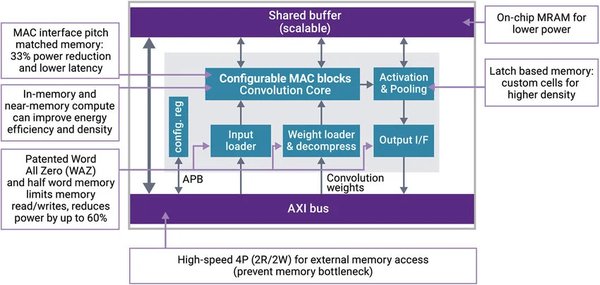

WSE-3集成了900,000个核心和44GB的SRAM内存,这些内存分布在各核心附近,以实现数据和计算的高度接近。NVIDIA H100则配备了80GB的HBM3内存,虽然内存容量更大,但其内存与核心之间的距离较远,可能导致更高的延迟。在计算能力方面,WSE-3的理论性能达到了256 exaFLOPs,而H100的性能则相对较低。

系统集成与扩展性

Cerebras的CS-3系统是WSE-3的配套硬件,支持液冷和风冷两种散热方式,能够有效管理芯片的热膨胀问题。NVIDIA的DGX H100系统则采用了内部NVSwitch和PCIe交换机,虽然扩展性较强,但在大规模集群中的互连成本较高。Cerebras的解决方案通过减少芯片数量,显著降低了系统的复杂性和功耗。

应用场景与性能对比

在实际应用中,WSE-3在解决复杂线性系统和模拟地下流体流动等任务中表现出色。例如,在模拟CO₂注入地下储层的实验中,WSE-3的性能远超H100。Cerebras的集群可以快速训练GPT-5等大规模模型,而NVIDIA的集群则需要更多的GPU和更高的互连成本。

未来展望

Cerebras Systems自2019年以来一直致力于挑战NVIDIA在AI训练领域的霸主地位。随着WSE-3的推出,Cerebras在性能和能效方面取得了显著进步。未来,随着制造工艺的进一步升级,Cerebras有望推出更强大的WSE-4,继续推动AI计算的发展。

结论

Cerebras WSE-3和NVIDIA H100代表了AI芯片领域的最高水平。WSE-3通过其独特的晶圆级设计和高效的内存分布,在性能和能效方面具有显著优势。然而,NVIDIA凭借其强大的生态系统和广泛的用户基础,依然在市场中占据重要地位。未来,这两家公司的竞争将继续推动AI技术的进步,为全球用户带来更强大的计算能力。