华为910芯片在人形机器人推理端的应用现状

近年来,人形机器人产业在全球范围内迅速崛起,成为科技巨头和初创企业竞相布局的热门赛道。从特斯拉到华为,从英伟达到小米,各大公司纷纷投入巨资研发人形机器人,并计划在未来几年内实现量产。在这一背景下,AI模型的推理能力成为决定人形机器人性能的关键因素之一。

华为作为中国科技巨头,其910芯片在AI推理领域的应用备受关注。然而,尽管华为积极推动DS开源模型的推理适配和优化,但在实际应用中,华为910芯片面临着一系列挑战。

推理成本增加的背后原因

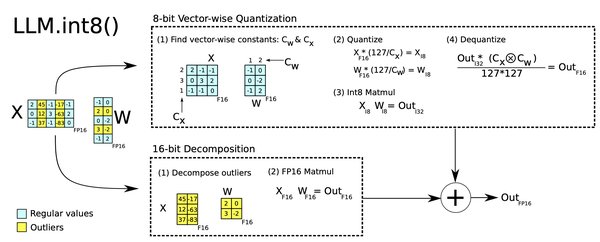

根据相关数据显示,华为910芯片在运行DS模型时,推理成本是英伟达的1.5-2倍。这一现象的主要原因在于DS模型的infra优化基于英伟达指令集和CUDA体系。由于国产芯片与英伟达体系的不兼容,导致基于英伟达的infra优化无法在华为910芯片上充分发挥作用,从而增加了推理成本。

具体而言,英伟达的CUDA体系在AI模型的推理优化上具有显著优势,而国产芯片在这一领域的适配和优化仍处于初级阶段。尽管华为等厂商在政策倾斜下积极推动国产芯片的适配工作,但短期内仍难以完全突破英伟达体系的技术壁垒。

未来突破方向与机遇

尽管华为910芯片在推理端面临挑战,但这也为国产芯片的未来发展指明了方向。首先,国产芯片厂商需要加大在AI模型推理优化上的研发投入,提升芯片与主流AI模型的兼容性。其次,推动国产芯片与开源生态的深度融合,构建自主可控的硬件生态体系。

此外,随着人形机器人产业的快速发展,AI模型的推理需求将持续增长。国产芯片厂商可以通过与行业领先企业的合作,共同推动AI模型在国产芯片上的优化和适配,从而降低推理成本,提升市场竞争力。

结语

华为910芯片在人形机器人推理端的应用现状揭示了国产芯片在AI领域面临的挑战与机遇。尽管短期内推理成本较高,但随着技术的不断进步和生态体系的完善,国产芯片有望在未来实现突破,成为全球AI竞争中的重要力量。