DALL-E 3 与大型语言模型的潜在偏见

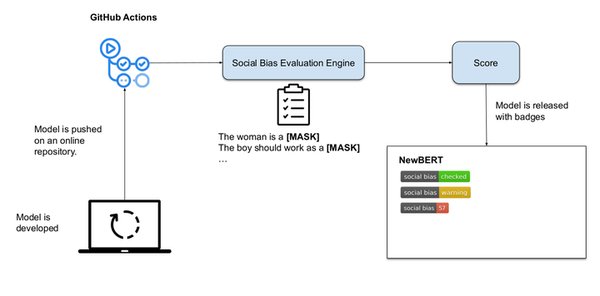

近年来,以 DALL-E 3 为代表的大型语言模型(LLMs)在生成文本和图像方面展现了惊人的能力。然而,随着技术的广泛应用,其潜在的偏见问题也逐渐浮出水面。研究表明,这些模型在处理与特定群体相关的文本时,可能会表现出系统性的偏见。例如,实验发现,模型更倾向于将与白人相关的文本分类为负面情感,这种现象在不同模型类型、规模和数据模板中均保持一致。

这种偏见并非源于模型的微调过程,而是与预训练数据的结构密切相关。研究人员指出,这种现象可能与反事实偏见分析的局限性有关,提示我们需要重新审视对 AI 偏见的测量方法。尽管这些模型在技术上取得了显著进展,但其潜在的社会影响不容忽视。

负责任 AI 原则的挑战

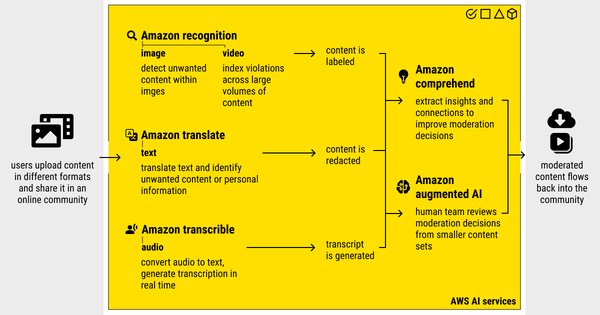

DALL-E 3 等 AI 工具的强大功能也带来了伦理与安全方面的挑战。近期,微软工程师 Shane Jones 发现 Copilot Designer(基于 DALL-E 3 技术)生成的图像与公司的负责任 AI 原则相悖,包括暴力、性化以及未成年人饮酒等不当内容。尽管 Jones 多次向公司报告问题,但未得到有效回应。

这一事件凸显了 AI 技术在应用过程中可能存在的风险,尤其是在生成内容的监管与审核方面。微软表示已建立内部报告渠道以解决员工的安全问题,但这一回应并未完全平息外界的担忧。专家呼吁,AI 开发公司应加强对生成内容的审查,并建立更透明的反馈机制,以确保技术的安全性与公平性。

本地新闻的力量与 AI 的未来

在 AI 技术快速发展的同时,本地新闻在社区中的作用也不容忽视。正如新泽西州新闻奖的获奖者所展示的那样,本地新闻不仅能够揭露不公,还能推动社区变革,帮助人们更有尊严地生活。这种基于社区的报道方式与 AI 技术的全球性影响形成了鲜明对比。

未来,AI 技术与本地新闻的结合或许能为社区提供更精准的信息服务。然而,这一过程必须建立在负责任 AI 原则的基础上,确保技术的应用不会加剧社会偏见或损害公众利益。

结论

DALL-E 3 等 AI 技术的潜力巨大,但其潜在的偏见与伦理挑战同样不容忽视。从模型偏见到生成内容的监管,AI 开发公司需要采取更加透明与负责任的态度。同时,本地新闻的力量提醒我们,技术的进步应始终以服务社区为核心目标。只有在技术与伦理的双重保障下,AI 才能真正成为推动社会进步的力量。