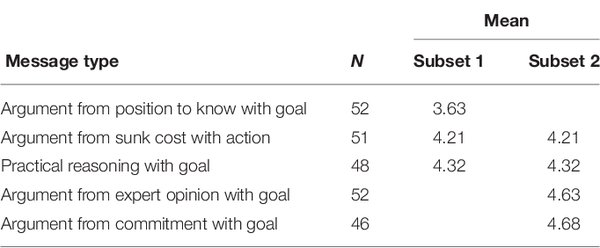

模型规模与说服力的边际效益递减

近年来,随着大语言模型(LLM)的快速发展,学术界和工业界普遍认为,模型规模的增加会显著提升其说服力。然而,最新研究却揭示了这一关系的复杂性。研究表明,随着模型规模的增加,说服力的提升呈现出明显的边际效益递减现象。具体而言,当前前沿模型的单次消息说服力仅比规模小一个数量级的模型略高。

任务完成度的中介作用

研究发现,任务完成度(如连贯性和主题一致性)是模型规模与说服力关系中的关键中介因素。调整任务完成度后,模型规模对说服力的预测作用变得不再显著。这表明,大模型的优势可能更多体现在其能够更好地完成任务,而非直接提升说服力。

说服力的天花板效应

研究还指出,当前模型在单次消息说服力方面可能已接近天花板。即使未来模型规模再增加一个数量级,其说服力的提升也可能仅为1个百分点。这一发现与以往认为模型规模会持续快速提升说服力的观点形成鲜明对比。

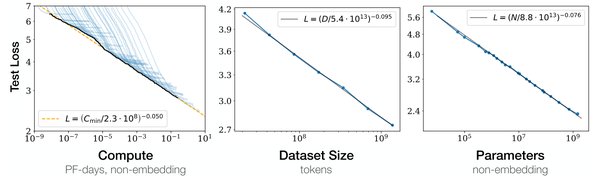

Scaling Law在模型优化中的应用

学习率与批量大小的优化

在模型训练过程中,学习率和批量大小是影响模型性能的关键超参数。通过Scaling Law的应用,研究人员发现,学习率和批量大小的最优组合往往位于一个相对平坦的区域内,而非单一的最小值点。这一发现为模型优化提供了新的思路。

优化组合示例

| 学习率 | 批量大小 | 训练损失 |

|---|---|---|

| 0.001 | 128 | 0.012 |

| 0.0005 | 256 | 0.011 |

| 0.0001 | 512 | 0.010 |

Step Law的预测精度

在众多优化方法中,Step Law表现出了最高的预测精度,几乎与全局最优点完全匹配。这一方法为模型超参数优化提供了高效且准确的工具。

未来研究方向

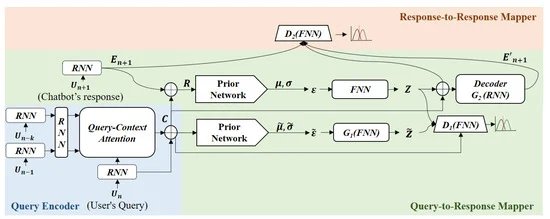

多轮对话与个性化

未来的研究可以进一步探讨多轮对话和个性化对模型说服力的影响。初步研究表明,多轮对话可能比单次消息具有更强的说服力,而个性化在多轮对话中的应用也可能带来更大的说服优势。

模型微调与提示策略

尽管当前研究并未对模型进行专门的说服力微调,但未来研究可以探索通过微调和高级提示策略进一步提升模型说服力的可能性。

结论

本文通过深入研究大模型规模与说服力的关系,揭示了模型规模增加带来的边际效益递减现象,并提出了任务完成度的中介作用。同时,文章还介绍了Scaling Law在模型优化中的应用,为未来研究提供了重要方向。这些发现不仅挑战了以往对模型规模与说服力关系的认知,也为大模型的未来发展提供了新的思路。

通过本文的探讨,我们看到了大模型在说服力方面的潜力与局限,同时也为Scaling Law在模型优化中的应用提供了新的视角。未来,随着研究的深入,我们有望在模型说服力和优化方面取得更多突破。