引言

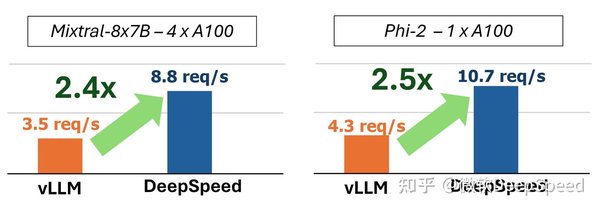

在当今的人工智能领域,大模型的推理效率一直是一个备受关注的问题。微软研究院最近开源的DeepSpeed-FastGen工具,通过创新的动态序列批处理技术和异构内存管理系统,显著提升了大模型推理效率,降低了硬件成本。本文将深入探讨这一工具的技术细节及其在实际应用中的表现。

动态序列批处理技术

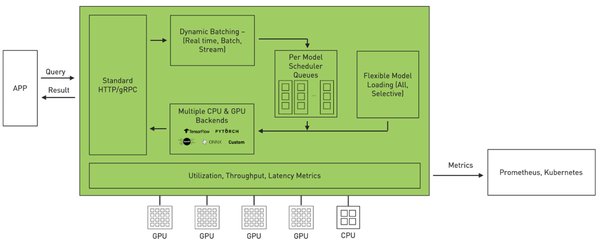

DeepSpeed-FastGen的核心技术之一是动态序列批处理。这一技术通过智能地管理输入序列的批处理过程,使得模型在推理时能够更高效地利用硬件资源。具体来说,动态序列批处理技术能够根据输入序列的长度和复杂度,动态调整批处理的大小,从而最大化硬件利用率。

技术优势

-

高效利用硬件资源:通过动态调整批处理大小,避免了硬件资源的浪费。

-

降低延迟:减少了推理过程中的等待时间,提高了整体响应速度。

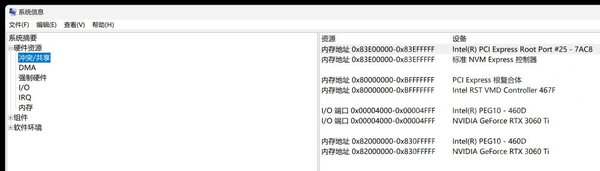

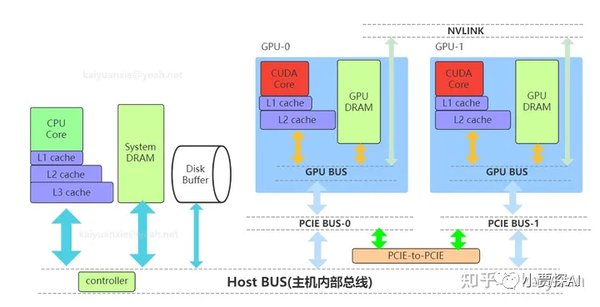

异构内存管理系统

另一个关键技术是异构内存管理系统。这一系统通过智能地管理不同类型的内存(如GPU内存和CPU内存),进一步提升了推理效率。

系统特点

-

智能内存分配:根据任务需求,动态分配GPU和CPU内存。

-

降低硬件成本:通过优化内存使用,减少了对高端硬件的依赖。

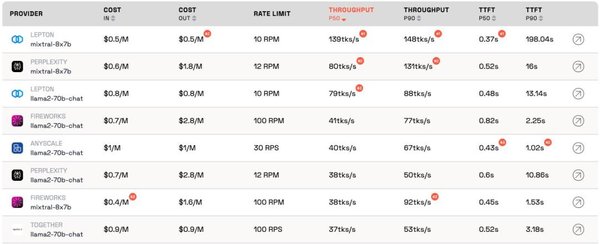

实际应用表现

在实际应用中,DeepSpeed-FastGen在NVIDIA A100上实现了130B模型的流畅运行,单节点可同时处理120个并发会话。这一表现展示了其在多个领域的广泛应用潜力。

应用场景

-

电商:在商品推荐和用户行为分析中,显著提升了处理速度和准确性。

-

医疗:在医学影像分析和病历处理中,提高了诊断效率和精度。

-

金融:在风险评估和交易分析中,增强了数据处理能力和响应速度。

开源生态的快速成长

DeepSpeed-FastGen的开源生态也在快速成长。HuggingFace已经集成了该工具的适配器,使得更多的开发者和研究者能够方便地使用和扩展这一工具。

开源优势

-

社区支持:通过开源,吸引了大量开发者和研究者的参与,推动了工具的持续改进。

-

广泛应用:开源生态的成长,使得DeepSpeed-FastGen在更多领域得到了应用和验证。

结论

DeepSpeed-FastGen通过其创新的动态序列批处理技术和异构内存管理系统,不仅显著提升了大模型推理效率,还降低了硬件成本。其在电商、医疗和金融等领域的实际应用表现,展示了其广泛的应用潜力。随着开源生态的快速成长,DeepSpeed-FastGen有望在更多领域发挥其重要作用。