引言

随着大语言模型(LLM)的快速发展,长文本处理能力成为制约其应用的关键瓶颈。清华大学和厦门大学等研究团队提出的LLMxMapReduce技术,通过创新的分帧处理方法和结构化通信协议,成功打破了这一限制,为大模型的长文本处理能力带来了革命性突破。

LLMxMapReduce技术原理

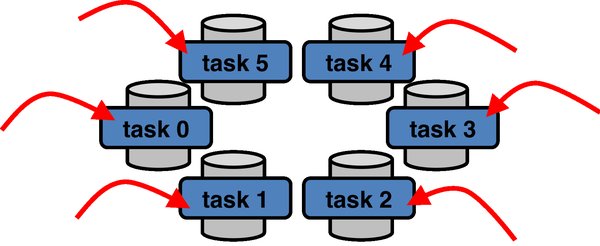

LLMxMapReduce技术借鉴了大数据领域的MapReduce框架,采用“分而治之”的策略,将长文本切分为多个片段,模型可以并行处理这些片段,并从中提取关键信息,最终汇总成完整的答案。这一过程包括三个阶段:

-

Map阶段:将长文本切分为多个小片段,并行处理并提取关键信息。

-

Collapse阶段:对提取的信息进行压缩和整合,处理跨片段冲突。

-

Reduce阶段:根据压缩后的信息汇总出最终答案,优先考虑置信度较高的结果。

技术创新点

LLMxMapReduce技术的两大核心创新点在于:

-

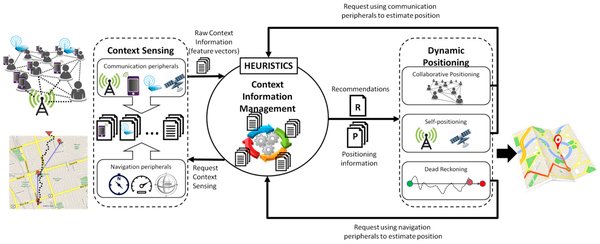

结构化通信协议:通过标准化的信息提取和整合流程,确保跨片段信息的高效处理。

-

上下文置信度校准机制:根据模型对每个片段结果的置信度进行校准,确保最终答案的准确性。

技术优势与实验验证

LLMxMapReduce技术在多个模型上表现出色,超越了包括Kimi和GPT-4在内的知名模型。具体实验结果表明:

-

InfiniteBench评测:结合LLMxMapReduce框架的Llama3-70B-Instruct模型以68.66的最高平均分数,超越了其他分治策略。

-

大海捞针测试:在处理1280K token的超长序列时,LLMxMapReduce技术展示了卓越的能力,测试结果全绿。

应用前景

LLMxMapReduce技术不仅在长文本处理方面表现出色,还具有广泛的通用性,可以应用于多种大模型,显著提升其长文本处理能力。未来,该技术有望在更多领域得到应用,如法律文书分析、长篇文档总结等。

结论

LLMxMapReduce技术通过创新的分帧处理方法和结构化通信协议,成功打破了大模型的记忆限制,为长文本处理提供了新的解决方案。这一技术的广泛应用,将为大模型的发展带来新的机遇和挑战。