知识蒸馏的定义与目标

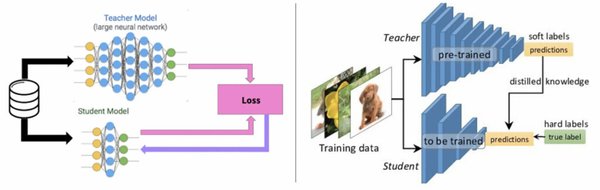

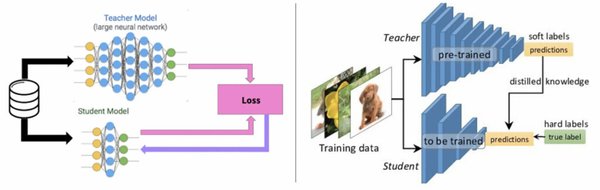

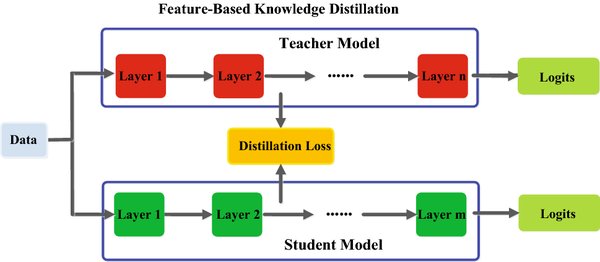

知识蒸馏是一种将大型复杂模型(教师模型)的知识迁移到小型高效模型(学生模型)的技术。其目标是在保持模型性能的同时,显著降低模型的计算复杂度和存储需求,使其更适合在资源受限的环境中部署。具体而言,知识蒸馏通过模仿教师模型的输出,训练一个较小的学生模型,从而实现知识的传递。

核心技术:软标签与温度参数

知识蒸馏的核心技术之一是软标签(Soft Targets)。与传统的硬标签不同,软标签是教师模型输出的概率分布,表示每个类别的置信度。这种概率分布不仅提供了样本的类别信息,还包含了类间关系的信息,使得学生模型能够学习到更多关于数据的结构和类间关系的信息。此外,温度参数(Temperature Parameter)的引入,使得在训练过程中可以动态调整软标签的平滑程度,从而更好地传递知识。

典型应用场景

知识蒸馏在多个领域都有广泛的应用,包括:

-

移动端设备:通过知识蒸馏将大型卷积神经网络(如ResNet50)的知识迁移到小型网络(如MobileNet),可以在保持较高准确率的同时,显著减少模型参数和计算量,满足在移动设备或嵌入式系统上的部署需求。

-

高实时性系统:在智能驾驶场景中,特斯拉的HydraNet通过多教师蒸馏框架,融合了目标检测、语义分割、深度估计等多个模型的知识,使车载系统的推理延迟降低至43ms,满足实时决策需求。

-

大规模数据处理:在医疗影像领域,联影智能采用分层蒸馏策略,将3D卷积核的时空特征逐步迁移至轻量模型,部署于移动DR设备后,肺结节检测速度提升8倍,内存占用减少至原模型的1/20。

当前进展与核心挑战

知识蒸馏已在工业界广泛落地,如MobileNet和TinyBERT等模型。然而,当前仍面临一些核心挑战,包括:

-

极端压缩下学生模型性能受损:在极端压缩的情况下,学生模型的性能可能会受到显著影响。

-

非概率形式知识的迁移困难:如何有效提取模型的“暗知识”仍是待解难题。

未来发展方向

知识蒸馏的未来发展方向包括:

-

无监督蒸馏:探索在没有标注数据的情况下进行知识蒸馏的方法。

-

多模态蒸馏:实现不同模态间的知识转移,帮助模型更好地处理多模态数据。

-

结合量化和剪枝技术实现更高压缩率:通过结合量化和剪枝技术,进一步提升模型的压缩率和运行效率。

总结

知识蒸馏技术正在重新定义AI模型的演化轨迹。通过将复杂教师模型的知识迁移到简单学生模型,知识蒸馏显著降低了计算量和存储需求,提升了运行效率。未来,随着无监督蒸馏、多模态蒸馏以及结合量化和剪枝技术的进一步发展,知识蒸馏将在边缘AI部署与绿色AI算力优化中发挥更加重要的作用,推动AI在资源受限场景的规模化应用。