DeepSeek V3.5优化版的技术突破

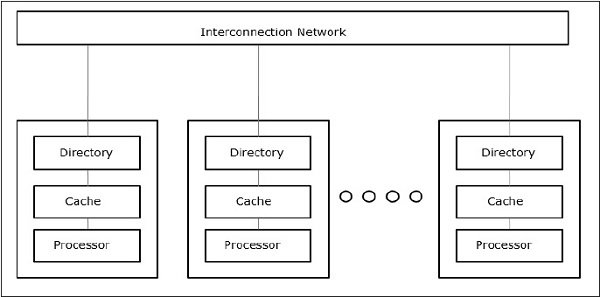

DeepSeek V3.5优化版在技术层面实现了多项突破,尤其是在并行计算优化和模型架构上。DeepSeek团队通过DualPipe算法,实现了计算与通信的完全重叠,减少了传统方法中的“流水线气泡”,显著提升了GPU的利用效率。此外,EPLB(专家并行负载均衡器)解决了MoE模型在分布式训练和推理中的负载不平衡问题,通过冗余专家策略确保不同GPU之间的负载平衡。

用户规模与行为特征

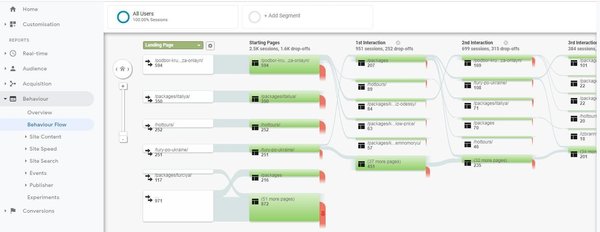

DeepSeek的用户规模在春节前达到峰值,DAU(日活跃用户)高达4000万,但节后回落至2400万。深度推理功能成为关键驱动力,70%的活跃用户依赖此功能,用户一旦体验后难以回归通用模型,印证其技术差异化优势。然而,用户活跃度的波动反映出节庆场景依赖性强,需通过功能迭代提升日常场景渗透率。

算力配置与硬件瓶颈

当前DeepSeek的算力配置包括1万张H800(训练)和1万张A100(推理),其中C端推理集群仅3000-4000张A100。无损用户上限仅500万 DAU,当前DAU远超此值,用户体验面临性能压力,亟需与云厂商合作扩容。此外,国产芯片适配困境也是DeepSeek面临的核心挑战之一,训练端深度绑定英伟达生态,国产卡适配成本高,短期内无采购计划。

商业模式与商业化潜力

DeepSeek在C端坚持免费模式,聚焦用户体验简化设计,避免复杂功能导致的用户流失。在B端,开源生态驱动二次开发,医疗、教育、金融领域已涌现应用案例。海外成本优势显著,API价格仅为GPT-4的1/30,吸引全球开发者接入。

行业影响与竞争格局

DeepSeek通过深度推理功能差异化与开源生态实现用户爆发,但其算力瓶颈、国产适配难题及用户留存压力构成核心挑战。未来需平衡技术激进创新与商业化稳健落地,同时借助政策支持突破硬件生态依赖,方能在全球AI竞争中持续领跑。华为昇腾、沐曦等10余家芯片厂商已适配DeepSeek模型,推动国产算力生态建设,刺激阿里、腾讯等大厂加速模型迭代。

未来展望

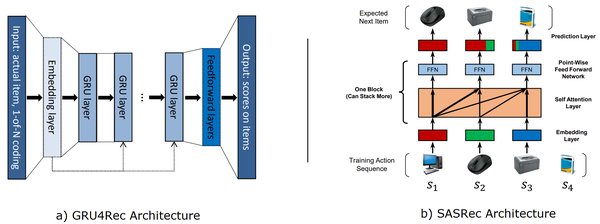

DeepSeek计划在2025年6月前推出V4与R2模型,重点押注后训练强化学习(RL)以突破智能上限,并探索MOE多模态架构。3月上线V3.5优化版,预计提升通用模型在长文本理解与推理效率。通过MLA(多头潜在注意力)与DeepSeekMoE架构降低KV缓存需求,提升推理效率。长期主义研发,放弃短期变现压力,专注AGI底层技术探索。

结论

DeepSeek V3.5优化版在技术层面实现了多项突破,通过开源生态与深度推理功能实现用户爆发。然而,算力瓶颈与国产适配难题仍是其面临的核心挑战。未来,DeepSeek需平衡技术创新与商业化落地,借助政策支持突破硬件生态依赖,以在全球AI竞争中持续领跑。