A100在DeepSeek模型部署中的关键作用

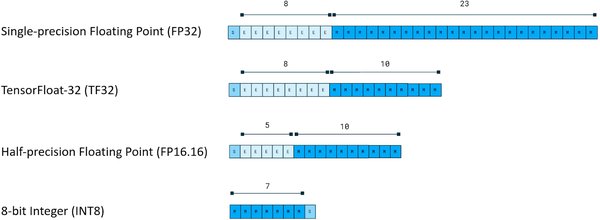

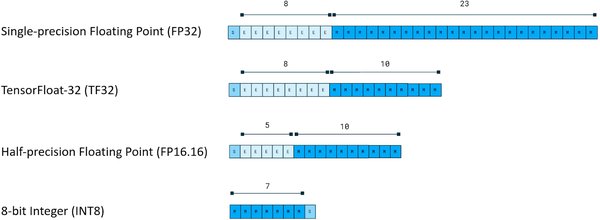

DeepSeek模型作为当前AI领域的热门技术,其部署和推理性能直接关系到用户体验和商业化潜力。A100 GPU凭借其强大的计算能力和广泛的硬件支持,成为DeepSeek模型部署的首选硬件之一。然而,DeepSeek原生版本采用FP8数据格式,对GPU芯片类型有严格限制,仅支持英伟达新型GPU(如Ada、Hopper架构芯片),这使得A100等老型号GPU无法直接部署。

为了解决这一问题,美团搜推机器学习团队开发了基于INT8量化的DeepSeek R1模型,实现了对A100等老型号GPU的兼容。INT8量化技术通过将数据位宽减半,显著降低了单次计算开销,同时保持了模型精度。在A100 GPU上,INT8量化模型的推理吞吐相比BF16模型提升了50%,极大地提升了模型部署的效率和成本效益。

INT8量化技术的突破

INT8量化技术的成功应用离不开分块量化和通道量化两种关键技术的支持。分块量化通过对权重矩阵的细粒度切分,将量化操作的范围控制在[128, 128]的矩阵内,减少了分布分散的出现概率,从而很好地控制了每次量化过程中的损失。通道量化则通过权重的每列为一组进行量化,在执行完INT8的矩阵乘法后,只需进行一次反量化计算,计算开销更低。

在实际应用中,美团技术团队首先将原生的FP8模型权重反量化成BF16,再分块量化成INT8类型。在推理过程中,激活值采用在线逐token-group的量化方式,最大程度地减少了activation的量化损失。通过这两种量化方法,INT8量化模型在GSM8K和MMLU两个数据集上的精度评估结果基本无损,证明了其在保持高精度的同时显著提升了推理性能。

A100在DeepSeek模型部署中的未来展望

尽管INT8量化技术成功解决了A100等老型号GPU的部署问题,但DeepSeek模型在硬件适配和商业化落地方面仍面临诸多挑战。首先,随着DeepSeek模型的用户规模不断扩大,算力瓶颈问题日益凸显。A100 GPU虽然性能强大,但在面对海量推理任务时,仍需进一步优化硬件配置和部署策略。

其次,国产GPU的适配难题也是DeepSeek模型未来发展的重要课题。目前,大陆市场主要依赖英伟达的H20等GPU进行AI推理,但出于性价比和合规性考虑,大陆科技大厂对国产GPU的需求日益旺盛。未来,DeepSeek模型需借助政策支持,突破硬件生态依赖,方能在全球AI竞争中持续领跑。

总结

A100 GPU在DeepSeek模型部署中发挥了关键作用,通过INT8量化技术显著提升了模型推理性能。然而,未来在硬件适配和商业化落地方面仍面临诸多挑战。我们期待通过技术突破和政策支持,推动DeepSeek模型在全球AI领域的持续创新和发展。