技术突破推动AI大模型训练加速

近年来,AI大模型的训练周期显著缩短,迭代速度加快,这一现象背后有多重技术突破的推动。首先,算力基础设施的爆发式增长为AI训练提供了强大的硬件支持。高性能计算集群和GPU/TPU等专用硬件的普及,使得大规模模型的训练成为可能。其次,算法与架构的创新也功不可没。例如,Sparse Attention等新型注意力机制的应用,有效降低了计算复杂度,提升了训练效率。

数据与训练策略优化

除了硬件和算法的进步,数据与训练策略的优化也是AI大模型训练加速的关键因素。通过数据增强、迁移学习和自监督学习等技术,模型能够在更少的数据和计算资源下达到更高的性能。此外,分布式训练和混合精度训练等策略的广泛应用,进一步提升了训练速度和资源利用率。

开源生态与工具链成熟

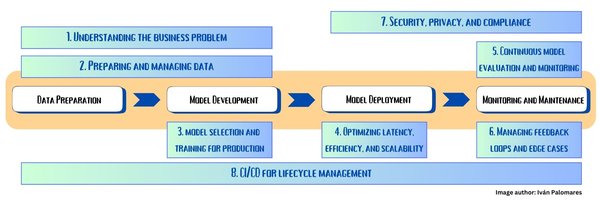

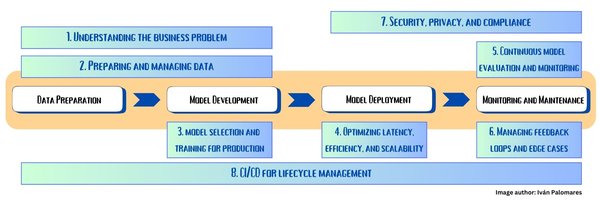

开源生态的繁荣和工具链的成熟,为AI大模型的快速迭代提供了有力支持。开源框架如TensorFlow、PyTorch等的普及,使得研究人员和开发者能够更便捷地实现和优化模型。同时,自动化工具和平台的出现,如AutoML和MLOps,进一步降低了AI开发的门槛,加速了模型的迭代和部署。

行业协作与资本推动

行业协作与资本的推动也是AI大模型训练加速的重要驱动力。各大科技公司和研究机构之间的合作,促进了技术的共享和创新。资本的涌入则为AI研发提供了充足的资金支持,推动了技术的快速发展和应用落地。

未来趋势:量子计算与光子计算

展望未来,量子计算和光子计算等新兴技术有望为AI大模型训练带来新的突破。量子计算的并行计算能力和光子计算的高效能效比,将进一步提升训练速度和能效。此外,AI训练自动化也将成为重要趋势,通过自动化工具和平台,实现从数据预处理到模型部署的全流程自动化,进一步加速AI技术的规模化落地。

面临的挑战

尽管AI大模型训练加速带来了诸多机遇,但也面临一些挑战。首先是能耗问题,大规模模型的训练需要消耗大量能源,如何在提升性能的同时降低能耗,是未来需要解决的关键问题。其次是数据伦理问题,如何在确保数据隐私和安全的前提下,充分利用数据进行模型训练,也是需要重点关注的方向。

AI大模型训练加速是技术突破、算法优化、硬件升级及行业协作等多重因素共同作用的结果。未来,随着量子计算、光子计算和AI训练自动化等技术的发展,AI技术将加速从研究阶段向规模化落地演进,但也需要在能耗和数据伦理等方面做出更多努力。