Qnn转换器后端:Qualcomm AI Engine Direct的核心技术

Qualcomm AI Engine Direct作为高通在人工智能领域的重要技术,其核心之一便是Qnn转换器后端。本文将深入探讨Qnn转换器后端的工作原理,以及其在多种深度学习框架中的应用。

Qnn转换器后端的工作流程

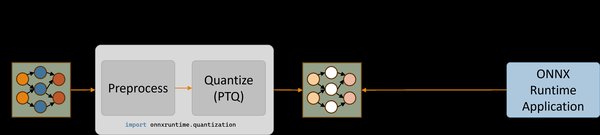

Qnn转换器后端是Qualcomm AI Engine Direct中不可或缺的一部分,其主要工作流程包括以下几个步骤:

-

前端翻译:将不同深度学习框架(如Tensorflow、TFLite、PyTorch和Onnx)的模型转换为通用中间表示(IR)代码。

-

通用IR代码:通过前端翻译生成的IR代码,Qnn转换器后端能够处理来自不同框架的模型,确保兼容性和一致性。

-

量化器:在IR代码的基础上,Qnn转换器后端进一步进行量化处理,优化模型的计算效率和内存占用。

-

后端优化:最终,Qnn转换器后端将优化后的模型转换为适合Qualcomm® 骁龙™处理器的高效代码,确保在移动设备上的高性能运行。

Qnn转换器后端的应用场景

Qnn转换器后端在多种应用场景中表现出色,特别是在以下领域:

-

嵌入式系统:通过Qnn转换器后端,嵌入式系统能够高效运行复杂的深度学习模型,提升设备的智能化水平。

-

物联网设备:物联网设备通常资源有限,Qnn转换器后端的优化能力使其能够在这些设备上实现高效的AI应用。

-

游戏开发:在游戏开发中,Qnn转换器后端能够优化AI模型的运行效率,提升游戏的交互性和沉浸感。

Qnn转换器后端的优势

Qnn转换器后端的优势主要体现在以下几个方面:

-

跨框架兼容性:支持多种深度学习框架,确保开发者能够灵活选择最适合的工具。

-

高效优化:通过量化器和后端优化,Qnn转换器后端显著提升了模型的计算效率和内存利用率。

-

高性能运行:最终生成的代码针对Qualcomm® 骁龙™处理器进行了优化,确保在移动设备上的高性能运行。

结语

Qnn转换器后端作为Qualcomm AI Engine Direct的核心技术,不仅在模型转换和优化方面表现出色,还为开发者提供了强大的技术支持。通过深入了解Qnn转换器后端的工作原理和应用场景,开发者能够更好地利用这一技术,实现高效、高性能的AI应用。

通过本文的解析,相信您对Qnn转换器后端有了更深入的理解。无论是嵌入式系统、物联网设备还是游戏开发,Qnn转换器后端都能为您带来显著的性能提升和开发便利。