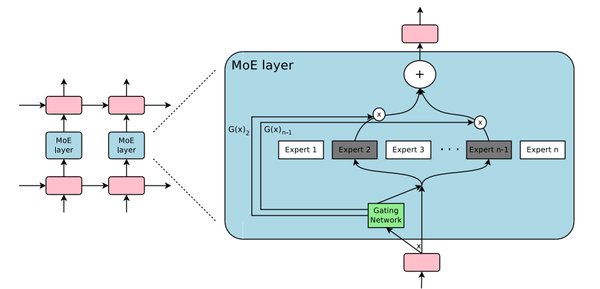

MoE架构的起源与演进

MoE(混合专家模型)架构自提出以来,逐渐成为AI领域的热门研究方向。其核心思想是将模型划分为多个“专家”模块,每个模块专注于处理特定的任务或数据子集。这种架构不仅能够显著提升模型的表达能力,还能通过动态路由机制优化计算资源的利用率。近年来,随着Transformer架构的普及,MoE在自然语言处理(NLP)等领域的应用得到了广泛关注。

DeepSeek的MoE创新

DeepSeek在MoE架构上的创新尤为突出。其推出的DeepSeek-R1模型通过动态知识唤醒技术和长文本处理能力,大幅提升了推理效率。具体来说,DeepSeek采用了细粒度专家和共享专家的设计,有效解决了传统MoE模型中专家数量有限与token信息丰富之间的矛盾。此外,DeepSeek还引入了设备受限的专家路由机制和通信负载均衡策略,进一步优化了分布式训练的效率。

DeepSeek的核心技术

-

细粒度专家设计:通过将多样的知识分配给有限的专家,避免专家在有限参数中学习过多不同类型的知识,从而提升专家的专业性。

-

共享专家机制:多个专家之间共享部分知识,减少参数冗余,提升模型的计算效率。

-

负载均衡策略:引入专家级负载loss和设备级负载loss,确保专家工作负载的均匀分布,避免路由崩溃和计算瓶颈。

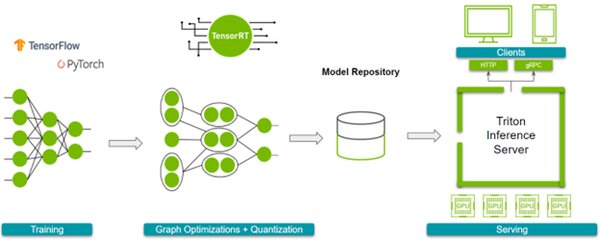

NVIDIA的硬件感知优化

NVIDIA在MoE架构上的硬件感知优化同样值得关注。其最新发布的Triton推理服务器通过动态批处理与自适应计算图分割技术,在A100显卡上实现了70B参数模型的推理速度突破,达到每秒60个token,较传统方案提升4.5倍。Triton服务器的核心创新在于将模型分解为可并行化的微算子,通过即时编译生成最优GPU指令序列,使计算密度提升至理论峰值的93%。

Triton服务器的三重优化

-

混合精度调度器:支持FP8等低精度运算,显著降低显存占用和通信带宽需求。

-

稀疏注意力核:优化注意力机制的计算效率,减少不必要的计算开销。

-

显存虚拟化技术:通过虚拟化技术扩展显存容量,支持更大规模的模型推理。

MoE架构的实际应用

MoE架构在实际应用中的潜力巨大。DeepSeek的开源项目DeepEP通信库,专为MoE模型设计,通过优化通信机制,显著降低了模型训练和推理过程中的通信开销。例如,在H800 GPU集群中,DeepEP的混合转发模式可将有效带宽提升至NVLink 153GB/s、RDMA 46GB/s,显著提升了系统的并行处理能力。

MoE架构的应用场景

-

大规模语言模型:通过MoE架构提升模型的表达能力和计算效率,支持更复杂的自然语言处理任务。

-

推荐系统:利用MoE的动态路由机制,优化推荐算法的计算资源分配,提升推荐效果。

-

实时交互场景:通过硬件感知优化技术,支持低延迟的实时推理,提升用户体验。

结论

MoE架构通过其独特的动态路由机制和硬件感知优化技术,正在成为AI领域的重要创新方向。DeepSeek和NVIDIA在这一领域的突破,不仅提升了模型的推理速度和计算效率,还为AI的工业化落地提供了核心解决方案。随着技术的不断演进,MoE架构有望在更多应用场景中发挥其巨大潜力,推动AI技术的进一步发展。