Transformer架构的技术突破

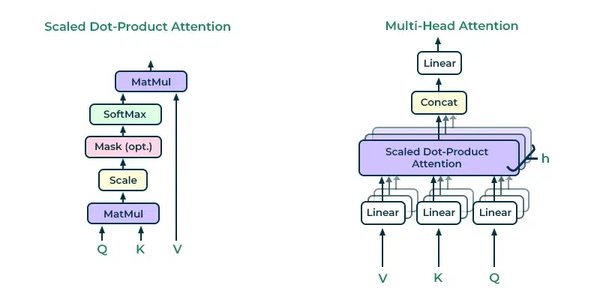

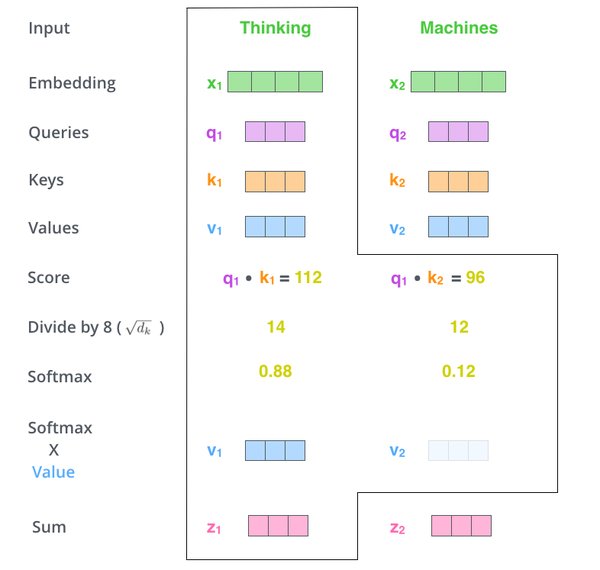

Transformer架构自2017年提出以来,彻底改变了自然语言处理(NLP)领域的格局。其核心创新在于自注意力机制(Self-Attention Mechanism),这一机制能够捕捉输入序列中不同位置之间的依赖关系,从而显著提升了模型的上下文理解能力。与传统的循环神经网络(RNN)和卷积神经网络(CNN)相比,Transformer架构在计算效率和并行化处理方面具有显著优势,为大规模语言模型的训练奠定了基础。

在Transformer架构的推动下,诸如BERT、GPT等模型相继问世,并在多项NLP任务中取得了突破性进展。例如,BERT通过双向上下文建模实现了更精准的语言理解,而GPT系列模型则通过生成式预训练展现了强大的文本生成能力。这些技术的积累为ChatGPT的诞生提供了坚实的技术基础。

ChatGPT的成功应用

ChatGPT作为基于GPT-3.5和GPT-4架构的对话式AI模型,展现了Transformer架构在生成式人工智能领域的巨大潜力。其成功不仅在于流畅的对话能力,更在于其能够处理复杂任务,如代码生成、知识问答和创意写作。ChatGPT的核心优势在于其强大的上下文理解能力和多轮对话的连贯性,这些特性直接受益于Transformer架构的设计。

然而,ChatGPT的应用也暴露出一些局限性。例如,在处理长文本或高分辨率输入时,标准注意力机制的二次复杂度成为计算效率的瓶颈。尽管稀疏注意力机制和线性注意力变体等优化技术被提出,但如何在保持模型性能的同时进一步提升效率,仍然是当前研究的重点方向。

Transformer架构的跨领域应用

雅各布·乌斯克尔特在TED AI大会上提到,他目前的工作重点是将深度学习技术引入生物化学领域。他创办的Inceptive公司致力于开发“生物软件”,利用AI技术设计更高效的药物。这一研究方向展示了Transformer架构在非传统领域的应用潜力。

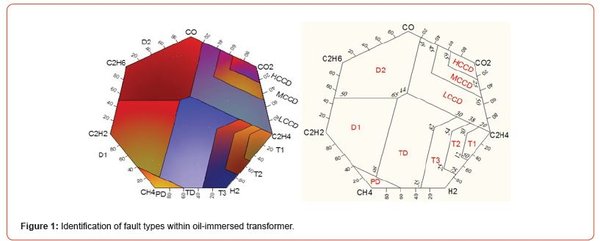

在生物化学领域,Transformer架构可以通过分析复杂的分子结构和生物数据,加速药物研发过程。例如,通过模拟蛋白质-蛋白质相互作用或预测分子活性,AI模型可以帮助科学家快速筛选潜在药物候选物,从而缩短研发周期并降低成本。

未来展望与挑战

尽管Transformer架构和ChatGPT取得了显著成就,但仍有许多挑战需要解决。以下是未来研究的几个关键方向:

1. 计算效率优化:探索混合架构、结构化稀疏模式和硬件感知算法设计,以降低计算成本并提升模型的可扩展性。

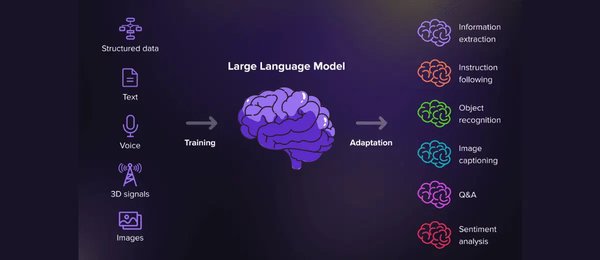

2. 多模态融合:将Transformer架构应用于图像、音频等多模态数据,开发更通用的AI模型。

3. 伦理与安全性:确保AI模型在应用过程中符合伦理规范,避免潜在的偏见和滥用。

4. 跨领域创新:将Transformer架构应用于更多领域,如生物化学、材料科学和金融,推动AI技术的跨界融合。

结语

Transformer架构的诞生不仅是技术上的突破,更是人类探索智能本质的重要里程碑。从ChatGPT的成功到生物化学领域的创新应用,Transformer架构展现了其在推动科技进步方面的巨大潜力。未来,随着技术的不断演进,AI将在更多领域发挥关键作用,为人类社会带来深远影响。