引言

在人工智能(AI)技术迅猛发展的今天,高性能计算(HPC)和AI加速器已成为推动技术进步的关键力量。TechInsights的最新研究揭示了三星HBM3内存的首个商用实例,该内存集成在AMD的MI300X AI加速器中,标志着AI计算进入了一个新的纪元。

三星HBM3内存的技术突破

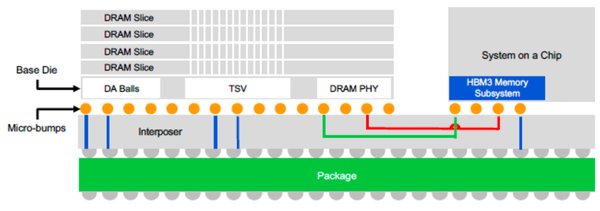

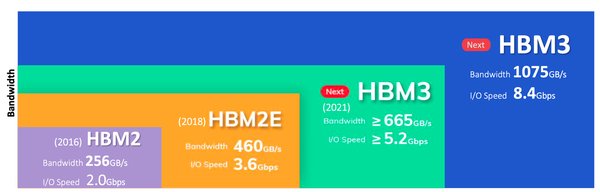

三星的HBM3内存技术带来了显著的性能提升,具体包括:

– 更高的带宽:HBM3内存的带宽显著高于前代产品,能够更快地处理大量数据,满足AI应用对高速数据处理的需求。

– 更低的延迟:通过优化内存架构,HBM3显著降低了数据传输的延迟,提高了AI加速器的响应速度。

– 更高的能效:HBM3在提供高性能的同时,也实现了更低的功耗,有助于降低数据中心的运营成本。

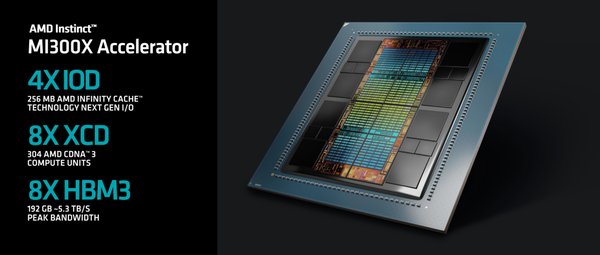

AMD MI300X AI加速器的集成优势

AMD的MI300X AI加速器集成了三星的HBM3内存,展现了其在AI计算领域的强大实力。以下是MI300X的主要优势:

– 高性能计算:MI300X利用HBM3的高带宽和低延迟特性,能够高效处理复杂的AI算法和模型。

– 能效优化:通过集成HBM3内存,MI300X在保持高性能的同时,显著降低了功耗,符合绿色数据中心的发展趋势。

– 广泛应用:MI300X适用于多种AI应用场景,包括机器学习、深度学习和数据分析等,为企业和研究机构提供了强大的计算支持。

人工智能应用的内存需求

随着AI技术的普及,对更快、更高效内存的需求日益增长。三星HBM3内存的商用实例,不仅满足了当前AI应用的内存需求,也为未来的技术发展奠定了基础。以下是内存技术在AI应用中的关键作用:

– 数据处理速度:高速内存能够加速AI算法的训练和推理过程,提高整体计算效率。

– 模型复杂性:随着AI模型的复杂性增加,对内存容量和带宽的需求也随之提升。

– 能效比:高效内存技术有助于降低AI系统的整体能耗,推动绿色计算的发展。

高性能计算与数据中心

TechInsights的研究表明,高性能计算和数据中心服务器是AI技术发展的重要支撑。三星HBM3内存与AMD MI300X AI加速器的结合,为数据中心提供了强大的计算能力,支持更复杂的AI应用和更大规模的数据处理。以下是数据中心在AI技术中的关键作用:

– 计算资源集中:数据中心集中了大量的计算资源,能够支持大规模的AI应用和数据处理。

– 能效管理:通过采用高效内存和AI加速器,数据中心能够优化能效比,降低运营成本。

– 技术升级:随着AI技术的不断进步,数据中心需要不断升级硬件设施,以满足日益增长的计算需求。

结论

三星HBM3内存与AMD MI300X AI加速器的结合,不仅提升了AI计算的性能,也为未来的技术发展开辟了新的道路。TechInsights的研究强调了先进内存解决方案对AI应用的重要性,并预示着高性能计算和数据中心服务器在AI技术中的关键作用。随着AI技术的不断进步,我们期待看到更多创新的内存和计算解决方案,推动AI技术的广泛应用和持续发展。