大模型安全的技术挑战

大模型安全目前面临多重技术挑战,主要集中在以下几个方面:

-

数据隐私保护

大模型在处理海量数据时,如何确保敏感信息不被泄露或滥用?通过加密数据、访问控制和数据脱敏等技术手段,可以有效保护数据隐私。 -

网络安全防御

面对日益复杂的网络攻击,如对抗性攻击和模型篡改,如何增强大模型的鲁棒性?引入对抗训练和模型监测机制是提升安全性的关键。 -

伦理与合规

大模型的应用是否符合伦理和法律标准?如何在创新与尊重原创之间找到平衡?确保算法的透明性和决策的公平性至关重要。

大模型安全的主要风险点

大模型在实际应用中存在诸多安全隐患,以下是主要风险点:

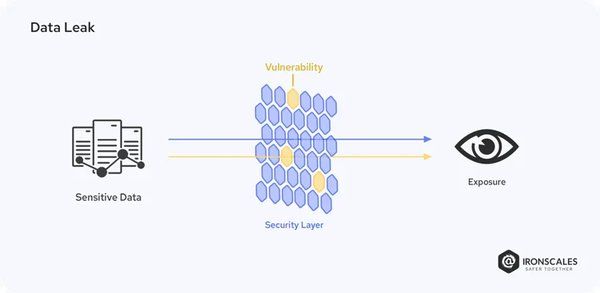

- 用户数据泄露

大模型在训练过程中可能涉及用户隐私信息,存在泄露风险。 - 算法复杂性

模型日趋复杂,可解释性目标难以实现,增加了安全评估的难度。 - 滥用与误用

人工智能被滥用或误用,可能导致社会秩序混乱,如虚假信息传播和隐私侵犯。

大模型与国家安全

大模型的安全问题不仅关乎个人隐私,还涉及国家安全:

- 敏感数据泄露

大模型处理的数据可能包含国家机密,一旦泄露将威胁国家安全。 - 网络攻击

人工智能技术使网络攻击更加隐蔽,对国家网络安全构成挑战。 - 经济与军事风险

人工智能在经济和军事领域的应用,可能带来新的安全风险。

大模型安全的治理路径

面对大模型安全挑战,需从多个层面开展治理:

- 技术创新

加强大模型的可解释性研究,开发可供审计的模型机制,提升模型对恶意数据的防御能力。 - 法律法规

加快建立适应人工智能时代特点的法律体系,明确AI系统的权责边界。 - 伦理规范

加强AI伦理研究,确立以人为本、安全可控的基本原则,并将其纳入AI系统的设计开发全过程。

国产大模型DeepSeek的安全问题

国产大模型DeepSeek的诞生标志着我国AI技术的加速发展,但其安全问题同样值得关注:

- 基座模型安全

大模型在生成文本时可能输出与现实不符的信息,导致误导性后果。 - 知识库安全

政府和企业核心数据资产存储于内部知识库中,需加强安全控制措施。 - 智能体安全

智能体与政府、企业内部系统相连,一旦遭受攻击,可能引发连锁反应。

构建完善的大模型应用安全治理体系

为应对大模型安全挑战,建议采取以下措施:

- 推动安全技术创新

鼓励具备“安全+人工智能”完整解决方案的企业加速技术成果转化。 - 组建产业联盟

引导相关企业发挥牵头作用,组建人工智能大模型安全联盟,助力大模型安全保障普及至千行百业。

结论

大模型安全是人工智能发展中的重要议题,需从技术、法律、伦理等多个层面综合治理。通过技术创新、法律法规完善和伦理规范的确立,我们可以构建一个更加安全、可信的大模型应用环境,推动人工智能技术的健康发展。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...