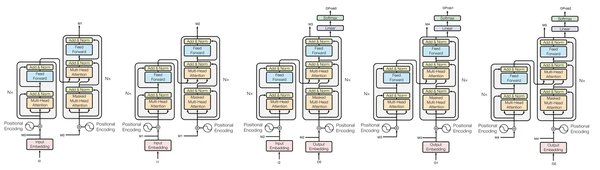

Transformer架构的演进

Transformer架构自2017年提出以来,迅速成为自然语言处理(NLP)领域的核心力量。其基于自注意力机制的模型设计,使得在文本生成、分类和问答等任务中表现出色。然而,随着应用场景的扩展,Transformer架构在处理长文本和多轮对话时逐渐显露出一些不足。

1.1 长文本处理的挑战

在处理长文本时,传统的Transformer模型往往面临推理速度慢和信息丢失的问题。例如,DeepSeek LLM在处理长文本时,模型的推理速度较慢,且容易出现信息丢失。为了解决这一问题,DeepSeek R1采用了更加高效的Transformer变体,如Longformer和BigBird,这些变体在处理长文本时表现出色,能够有效减少信息丢失。

1.2 多轮对话的优化

在多轮对话中,模型的上下文理解能力有限,容易产生歧义。DeepSeek R1通过引入多任务学习和强化学习,提升了模型的泛化能力和对话质量。多任务学习使模型能够同时学习多种任务,而强化学习则使模型在与环境的交互中不断优化自身策略。

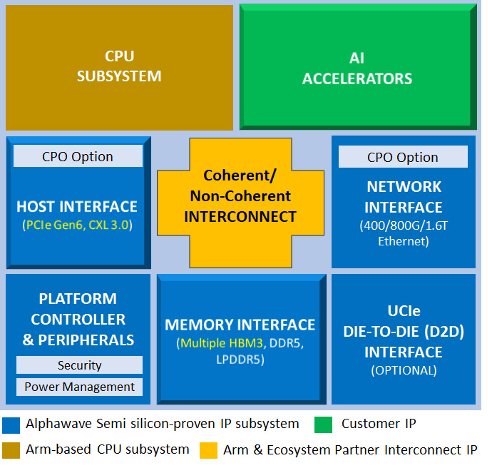

AI推理的未来趋势

随着AI技术的不断发展,AI推理逐渐成为CSP业者的重心。集邦咨询报告预测,2025年全球AI服务器出货量将大幅增长,CSP业者将更积极发展成本较低的自有ASIC方案。

2.1 ASIC芯片的优势

ASIC芯片在功耗、成本和算力利用效率方面具有显著优势。国泰君安指出,随着软件生态的成熟,ASIC有望更广泛地应用于AI推理与训练。例如,谷歌TPU的算力利用率可超过50%,这为AI推理提供了更高效的解决方案。

2.2 ASIC在AI推理中的应用

ASIC专为特定任务设计,算力利用率可能更高。例如,谷歌TPU的算力利用率可超过50%,这为AI推理提供了更高效的解决方案。随着ASIC芯片的普及,AI推理将迎来更高效、更低成本的解决方案。

结论

Transformer架构的演进和ASIC芯片的普及,为AI推理带来了新的发展机遇。未来,随着技术的不断进步和应用场景的扩展,AI推理将在更多领域展现其强大的应用潜力。开发者和企业应深入理解和应用这些技术,以提升开发效率和业务价值。

| 技术 | 优势 | 应用场景 |

|---|---|---|

| Transformer架构 | 高效处理长文本 | 文本生成、分类、问答 |

| ASIC芯片 | 高算力利用率 | AI推理、训练 |

通过以上分析,我们可以看到,Transformer架构和ASIC芯片的结合,将为AI推理带来更高效、更低成本的解决方案。未来,随着技术的不断进步,AI推理将在更多领域展现其强大的应用潜力。