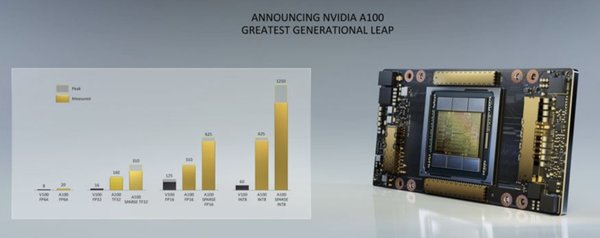

A100芯片:AI算力的黄金枷锁

A100芯片作为英伟达的旗舰产品,已成为AI大模型训练的绝对王者。其强大的计算能力支撑了从ChatGPT到Sora等众多AI应用的诞生。然而,A100芯片的高昂成本和巨大能耗也成为了AI发展的“黄金枷锁”。

根据OpenAI的数据,训练ChatGPT消耗了3640PF-days的算力,相当于每秒计算1000万亿次,连续计算3640天。这一过程依赖上万颗A100芯片,单颗芯片售价超过3万美元,总成本高达数亿美元。此外,10万卡H100集群的年电费高达1.239亿美元,凸显了A100芯片在能耗上的巨大压力。

DeepSeek与OpenAI的技术竞争

DeepSeek作为中国AI领域的后起之秀,凭借其创新的算法优化和低成本策略,正在挑战OpenAI的领先地位。DeepSeek通过优化GPU低级汇编语言PTX,大幅降低了算力需求,并在全球直播中展示了其894块A100显卡的实时数据,反驳了马斯克对其数据造假的质疑。

DeepSeek的技术路线与OpenAI的“暴力计算”形成鲜明对比。OpenAI依赖大规模算力和数据投入,而DeepSeek则通过算法创新和资源优化,实现了在有限资源下的高性能表现。这种差异不仅体现在技术层面,也反映了中美AI发展的不同战略。

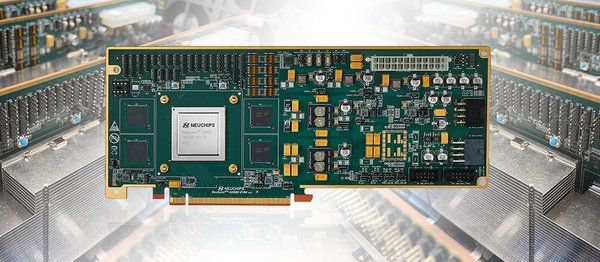

ASIC芯片:AI算力的未来?

随着AI从训练阶段进入推理阶段,ASIC芯片逐渐成为新的焦点。与通用GPU相比,ASIC芯片在成本和能耗上具有显著优势。例如,谷歌定制的TPU v5芯片在Llama-3推理场景中,单位算力成本较H100降低70%。亚马逊的Trainium芯片年节省电费超千万美元。

ASIC芯片的崛起不仅是一场技术革命,更是一本关于效率、成本和话语权的商业启示录。博通作为ASIC设计服务的最大受益者,预计2027年ASIC市场规模将达到900亿美元。这一趋势可能重塑AI芯片领域的竞争格局,甚至挑战英伟达的市场主导地位。

英伟达的挑战与未来

尽管英伟达在AI芯片领域占据绝对优势,但其面临的挑战也在加剧。高昂的成本和冗余的能耗使得通用GPU在推理阶段显得“大材小用”。与此同时,DeepSeek等新兴企业通过算法优化和ASIC芯片的探索,正在开辟新的技术路径。

英伟达的未来不仅取决于其技术创新能力,还在于其如何应对ASIC芯片的崛起和全球AI算力需求的变化。随着AI从“大力出奇迹”的训练军备竞赛转向追求能效的深水区,英伟达需要在技术与商业之间找到新的平衡点。

结论

A100芯片作为AI算力的核心硬件,既推动了AI技术的快速发展,也暴露了其成本与能耗的局限性。DeepSeek与OpenAI的技术竞争、ASIC芯片的崛起,以及英伟达的市场挑战,共同描绘了AI芯片领域的复杂图景。在这场技术与商业的博弈中,谁能率先突破算力经济瓶颈,谁就将主导AI的未来。