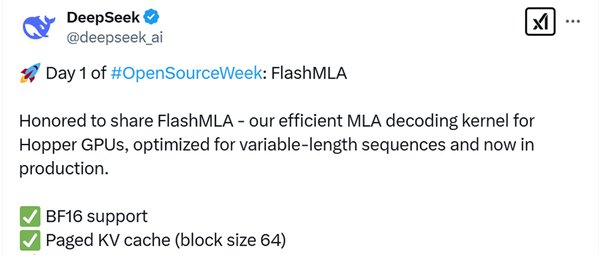

2025年,AI领域迎来了一项重大技术突破。中国AI开发企业DeepSeek在“开源周”期间,发布了首个开源代码库FlashMLA。这是一个专为Hopper GPU优化的高效MLA(Multi-Length Attention)解码内核,旨在解决AI任务中可变长度序列处理的难题。这一开源举措不仅展现了DeepSeek的技术实力,也为全球开发者提供了强大的工具,推动了高性能AI应用的落地。

FlashMLA的核心优势

FlashMLA的发布标志着AI模型解码效率的显著提升。它通过以下技术特性,突破了传统GPU算力的瓶颈:

-

Hopper GPU优化:FlashMLA充分利用了NVIDIA Hopper架构的强大性能,支持高达3000 GB/s的内存带宽和580 TFLOPS的计算能力。

-

BF16支持:采用Brain Float 16格式,在减少内存占用的同时保持了高精度,特别适合大规模AI模型。

-

分页KV缓存:以64块为单位的动态分页机制,显著降低了内存开销和延迟,提升了实时AI应用的性能。

-

可变长度序列处理:针对自然语言处理和生成式AI中常见的可变长度序列,FlashMLA通过动态调度和内存优化,确保了高效的计算性能。

FlashMLA的应用场景

FlashMLA的高性能特性使其在多个领域具有广泛的应用潜力:

-

医疗健康:实时分析患者数据,提升诊断效率。

-

金融科技:优化高频交易算法,提高决策速度。

-

自动驾驶:加速复杂场景的实时处理,增强系统响应能力。

-

生成式AI:提升大语言模型的解码速度,改善用户体验。

开源生态与开发者价值

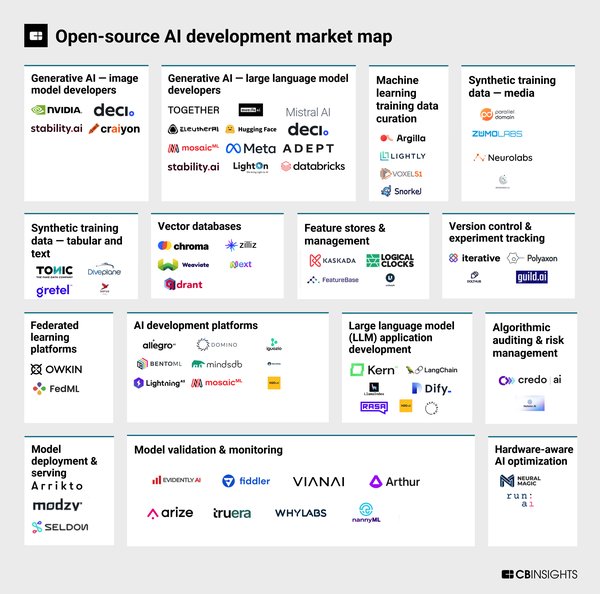

DeepSeek的开源策略不仅推动了技术进步,也为开发者提供了巨大的价值:

-

代码透明性:开发者可以在GitHub上访问完整的FlashMLA代码库,并根据需求进行定制和优化。

-

社区协作:开源模式鼓励全球开发者共同创新,推动AI技术的快速迭代。

-

硬件兼容性:FlashMLA不仅支持Hopper GPU,还适配了MetaX、Moore Threads等多种GPU架构,进一步扩大了其应用范围。

DeepSeek的愿景与未来

FlashMLA的发布是DeepSeek开源战略的第一步。DeepSeek表示,未来将继续开源更多代码库,以透明的方式分享其技术进展。作为一家探索通用人工智能(AGI)的企业,DeepSeek致力于通过开源生态推动AI技术的普及与创新。

总结

FlashMLA的发布不仅是Hopper GPU性能的突破,更是AI技术发展的重要里程碑。通过开源这一高效解码内核,DeepSeek为全球开发者提供了强大的工具,推动了高性能AI应用的落地。未来,随着更多开源项目的发布,DeepSeek有望在AI领域发挥更大的影响力,为技术创新和行业发展注入新的活力。