近年来,AI大模型的快速发展引领了人工智能领域的革命。从Transformer架构的提出到BERT模型的广泛应用,AI技术不仅在自然语言处理(NLP)领域取得了突破,还逐步扩展到多模态任务和通用任务解决能力。本文将深入探讨BERT模型的发展历程及其在AI大模型中的核心地位。

Transformer架构的诞生与影响

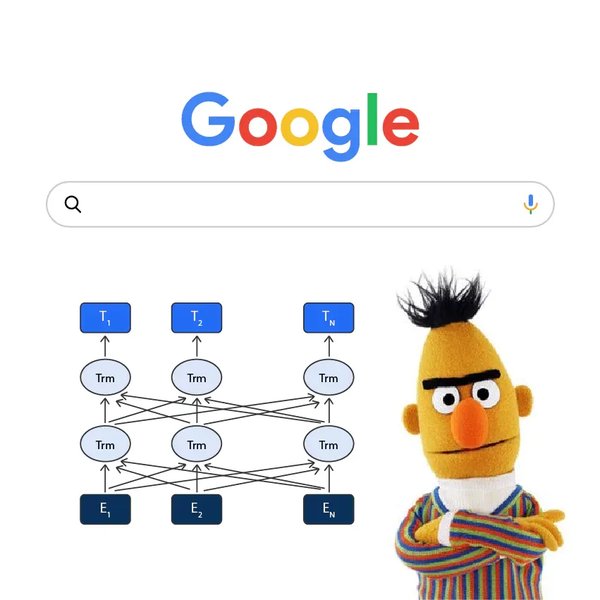

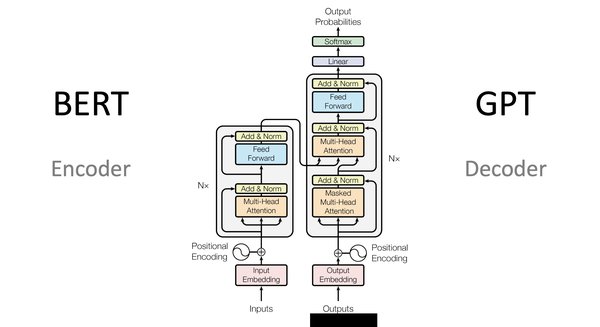

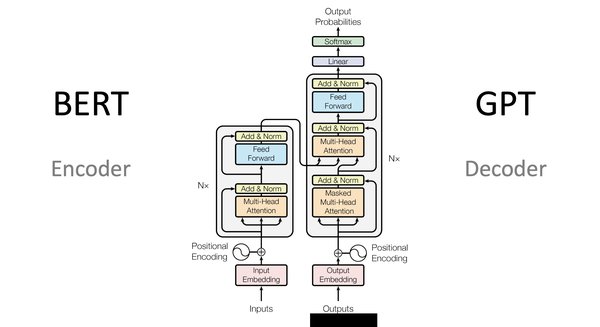

Transformer架构是BERT模型的基础。它通过自注意力机制(Self-Attention)实现了对长距离依赖关系的有效捕捉,从而在机器翻译等任务中取得了显著效果。Transformer的提出标志着NLP领域从传统的循环神经网络(RNN)和卷积神经网络(CNN)向更高效的架构转变。

BERT模型的创新与优势

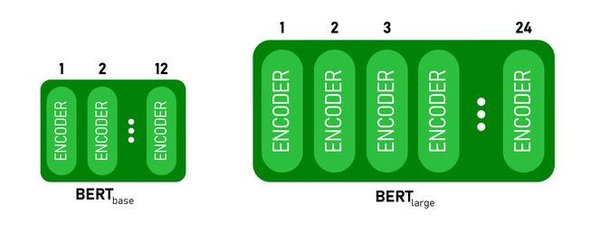

BERT(Bidirectional Encoder Representations from Transformers)模型在Transformer的基础上进行了创新。与传统的单向语言模型不同,BERT采用双向训练方式,能够同时捕捉上下文信息。这种设计使其在多项NLP任务中表现优异,例如文本分类、问答系统和命名实体识别。

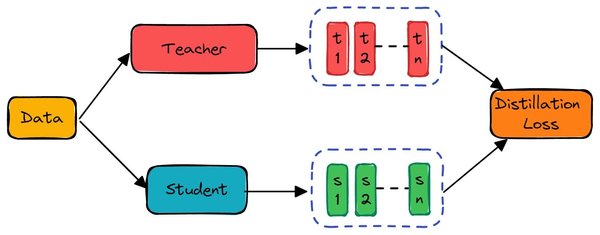

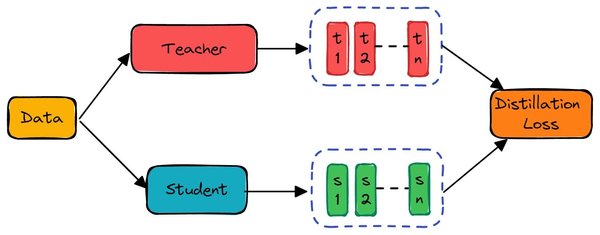

BERT的成功还归功于其大规模预训练和迁移学习的应用。通过在海量文本数据上进行预训练,BERT能够学习到丰富的语言特征,从而在特定任务中通过微调实现高效迁移。这种模式不仅降低了训练成本,还提高了模型的泛化能力。

参数规模与数据模态的融合

随着AI大模型的发展,参数规模的增长成为提升模型性能的关键因素。从最初的几亿参数到如今的千亿级参数,模型的表现能力得到了显著提升。此外,数据模态的融合也成为了研究热点。BERT模型的多模态扩展(如视觉BERT)展示了其在图像和文本联合任务中的潜力,为通用任务解决能力奠定了基础。

从BERT到通用任务解决

BERT模型的成功为AI大模型的应用提供了范例。在人形机器人领域,AI大模型通过迁移学习和多模态融合,能够赋予机器人理解自然语言、感知环境并执行复杂任务的能力。例如,机器人可以通过BERT模型理解人类指令,并结合视觉数据完成特定操作。

未来展望

随着技术的不断进步,AI大模型在通用任务解决能力上的潜力将进一步释放。从文本处理到多模态任务,BERT模型及其衍生技术将继续推动人工智能的发展。未来,AI大模型有望在人形机器人、智能助手等领域实现更广泛的应用,为人类生活带来更多便利。

BERT模型作为AI大模型的重要代表,不仅推动了NLP领域的进步,还为通用任务解决能力的研究提供了宝贵的经验。随着参数规模的增长和数据模态的融合,AI大模型将继续引领人工智能技术的未来。