引言

在生成AI时代,AI创作正逐渐成为创意领域的重要工具。ComfyUI与Wan2.1模型的结合,为文生视频和图生视频的创作提供了强大的技术支持。本文将详细介绍如何利用这些工具实现高效的AI创作流程。

ComfyUI与Wan2.1模型简介

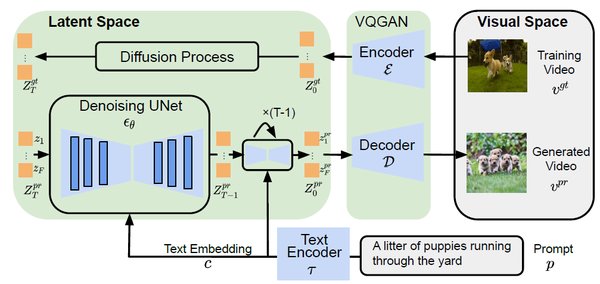

ComfyUI是一个功能强大的用户界面,专为AI创作设计。Wan2.1模型则是一系列先进的扩散模型,能够实现高质量的文生视频和图生视频生成。两者的结合,为创作者提供了前所未有的创作体验。

文生视频工作流

要实现文生视频的创作,首先需要下载并安装以下模型文件:

wan2.1_t2v_1.3B_fp16.safetensors

这些文件应存放在ComfyUI/models/diffusion_models/目录下。使用这些模型,创作者可以轻松将文本转化为生动的视频内容。

图生视频工作流

图生视频的创作流程同样需要下载特定的模型文件:

-

wan2.1_i2v_480p_14B_bf16.safetensors

其中,clip_vision_h.safetensors文件需存放在ComfyUI/models/clip_vision/目录下。这些模型能够将静态图像转化为动态视频,为创作者提供更多的创作可能性。

模型选择与性能优化

在实际操作中,创作者可以根据硬件条件和创作需求选择不同的模型版本。例如,16位模型适合高性能硬件,而fp8模型则更适合内存有限的设备。此外,720p模型在硬件条件允许的情况下,能够生成更高分辨率的视频内容。

结语

ComfyUI与Wan2.1模型的结合,为AI创作开辟了新的领域。通过掌握这些工具的使用方法,创作者可以更加高效地实现文生视频和图生视频的创作。未来,随着技术的不断进步,AI创作将为我们带来更多惊喜与可能性。

通过本文的介绍,相信读者已经对如何使用ComfyUI和Wan2.1模型进行AI创作有了初步的了解。希望这些内容能够帮助您在AI创作的道路上走得更远。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...