DeepSeek模型:开源与低成本的AI新星

DeepSeek模型自发布以来,迅速成为AI领域的热门话题。其开源特性和低成本优势,吸引了全球开发者和企业的广泛关注。DeepSeek-V3/R1模型不仅在推理、数学和代码任务中表现出色,还通过开源的方式为开发者提供了“巨人的肩膀”,使其能够低成本打造高质量私有模型,提升业务竞争力。

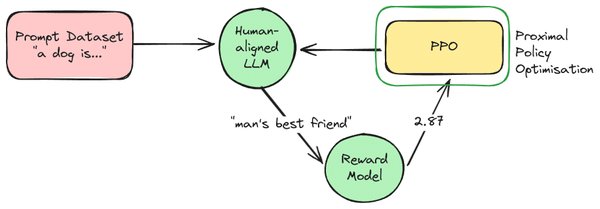

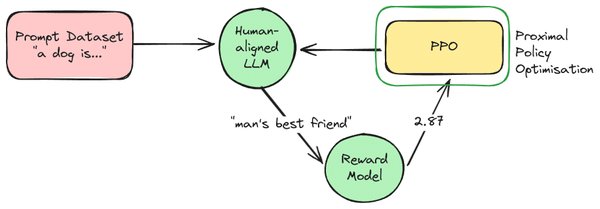

PPO技术:强化学习的核心

在DeepSeek模型的训练过程中,强化学习(Reinforcement Learning, RL)扮演了重要角色,尤其是近端策略优化(Proximal Policy Optimization, PPO)技术。PPO是一种高效的强化学习算法,广泛应用于大型语言模型的训练中。DeepSeek通过结合PPO技术,实现了模型推理能力的显著提升。

DeepSeek的PPO应用

DeepSeek在训练过程中采用了多阶段的PPO技术:

-

初始冷启动微调(SFT):通过收集高质量的长链推理数据集,对DeepSeek-V3-Base进行微调,为后续的强化学习奠定基础。

-

第一阶段推理导向的RL:使用大规模推理导向的RL进一步微调模型,生成更多SFT数据用于下一阶段训练。

-

第二阶段SFT:结合推理和非推理数据,进一步优化模型。

-

第二阶段RL:通过最终RL阶段,使模型更符合人类偏好,提升其帮助性、无害性和推理能力。

Colossal-AI:开源工具箱助力微调

Colossal-AI发布了开源大模型后训练工具箱,为开发者提供了多种微调和强化学习工具链,支持多种硬件和训练加速技术。工具箱中的关键功能包括:

-

低成本监督微调(SFT):支持DeepSeek-V3/R1 671B模型的低成本微调,最低硬件要求降低近10倍。

-

强化学习工具链:包含PPO、GRPO、DPO、SimPO等算法,支持自定义奖励函数和损失函数。

-

灵活的并行策略配置:支持数据并行、模型并行、专家并行等多种策略,适应不同硬件规模。

微调DeepSeek-V3/R1的步骤

-

数据集准备:使用JSONL格式的文件作为输入数据集,兼容Huggingface chat template。

-

模型权重准备:使用BF16权重进行微调,确保更好的微调效果。

-

启动微调脚本:使用Colossal-AI提供的一键启动脚本,快速完成微调。

知识蒸馏:低成本高效训练的秘密

知识蒸馏是DeepSeek模型训练中的另一大亮点。通过使用大模型(如o1)来训练小模型,开发者可以在低成本下获得高性能的私有模型。例如,使用o1的API进行监督微调,可以在数学问题上超越o1-preview,并展现出强大的泛化能力。

未来展望:AI领域的范式转变

DeepSeek的成功不仅在于其技术优势,更在于其开源和低成本策略,为AI领域带来了范式转变。通过结合PPO等强化学习技术和Colossal-AI的开源工具箱,开发者可以低成本打造高质量私有模型,推动AI技术的广泛应用和商业化落地。

DeepSeek模型和PPO技术的结合,为AI领域带来了新的可能性。无论是企业还是开发者,都可以通过这一技术组合,低成本高效地构建私有模型,提升业务竞争力。未来,随着更多开源工具和技术的出现,AI领域将迎来更加繁荣的发展。