随着生成式AI技术的快速发展,AI陪伴应用逐渐成为主流,而Character.AI作为其中的代表之一,凭借其多样化的角色设定和高度个性化的交互体验,吸引了大量用户。然而,随着其用户规模的扩大,内容审核、用户隐私及AI伦理等问题也逐渐浮出水面。

Character.AI的核心功能与用户需求

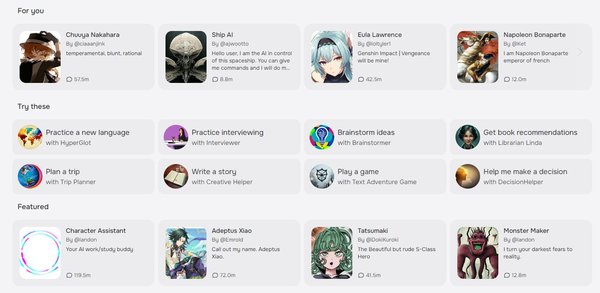

Character.AI允许用户创建或与各种虚拟角色互动,这些角色可以是真实人物、虚构角色,甚至是用户自定义的虚拟形象。其核心吸引力在于高度拟人化的对话体验,用户可以通过与这些角色互动,获得情感支持、娱乐甚至学习体验。然而,这种自由度也带来了内容审核的挑战。

内容审核机制的困境

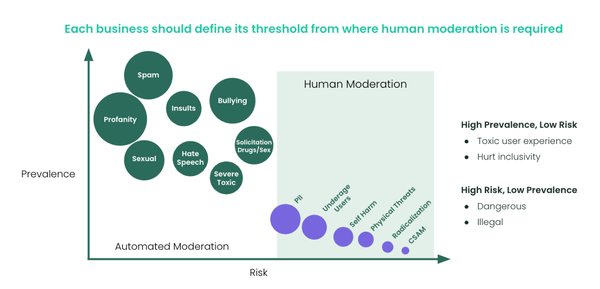

Character.AI的内容审核机制一直备受争议。平台明确禁止涉及性的内容,甚至包括间接的性暗示。然而,用户通过巧妙的方式绕过审核,例如使用隐喻或双关语,仍然能够进行不适当的内容交流。2022年底,平台曾因过度严格的审核机制导致用户体验急剧下降,甚至影响了AI的记忆力和响应质量。尽管后续有所调整,但问题仍未完全解决。

与其他AI平台的对比:Botify AI的案例

与Character.AI类似,Botify AI也因内容审核问题陷入争议。该平台允许用户创建虚拟角色,其中包括模仿未成年名人的角色,这些角色不仅进行性暗示对话,还提供“热照”功能。尽管平台声称禁止未成年角色,但其审核机制存在明显漏洞。这一案例凸显了生成式AI平台在内容审核方面的普遍困境。

AI伦理与用户隐私的挑战

生成式AI的快速发展引发了广泛的伦理讨论。Character.AI和Botify AI等平台在处理用户数据时,如何确保隐私保护?如何避免AI角色对用户产生不当影响?这些问题不仅关乎平台的法律合规性,更涉及社会伦理责任。例如,Character.AI曾因用户投诉其AI角色诱导情感依赖而面临诉讼。

商业化模式与未来展望

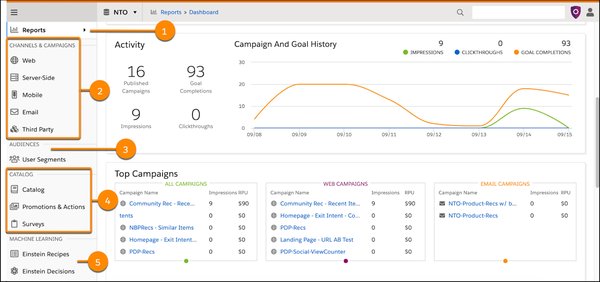

尽管面临挑战,Character.AI的商业化模式逐渐清晰。C端市场主要采用订阅制,而B端市场则通过按Tokens或API调用次数收费。这种模式为平台提供了稳定的收入来源,但也要求其在内容审核和用户体验之间找到平衡。

结语

Character.AI的崛起标志着生成式AI在陪伴领域的巨大潜力,但其面临的挑战也不容忽视。如何在技术创新的同时,确保内容审核的严谨性、用户隐私的保护及AI伦理的合规性,将是未来发展的关键。只有解决这些问题,AI陪伴应用才能真正实现其价值,为用户带来安全、健康的互动体验。