深度学习在时间序列预测中的创新

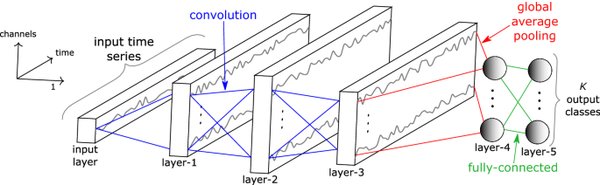

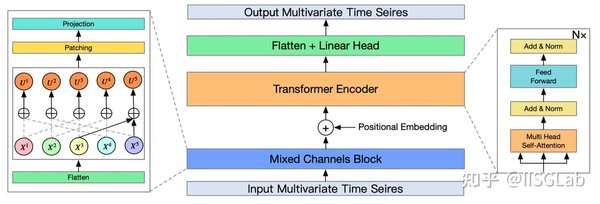

2023年,深度学习在时间序列预测领域取得了缓慢但稳定的进展。Neurips、ICML和AAAI等会议上出现了多种transformer结构的改进,如BasisFormer、Crossformer、Inverted transformer和Patch transformer。这些创新不仅提升了预测精度,还降低了计算成本,为时间序列分析带来了新的可能性。

Patch transformer的突破

Patch transformer作为一种新型的transformer结构,通过将时间序列数据分割成多个patch,有效地捕捉了局部和全局的时间依赖关系。这种方法不仅提高了模型的表达能力,还减少了计算复杂度,使得在大规模数据集上的应用更加高效。

跨模态数据合成的CrossVIVIT

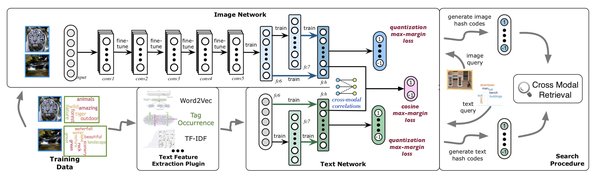

除了单一的transformer结构,研究人员还开发了将数值时间序列数据与文本和图像合成的新体系结构CrossVIVIT。这种跨模态的方法充分利用了不同类型数据的互补性,进一步提升了预测模型的性能。

直接应用于时间序列的LLM

近年来,直接应用于时间序列的LLM(大语言模型)也取得了显著进展。例如,TimesFM等模型通过零样本学习和神经缩放定律,展示了在时间序列预测中的强大能力。与传统的基于预训练语言模型的微调方法相比,这些新模型在迁移学习方面表现更为出色。

时间序列正则化技术的创新

在时间序列正则化/规范化技术方面,研究人员提出了新形式的技术san,通过引入更复杂的正则化策略,有效地防止了模型过拟合,提高了泛化能力。

结论

2023年,深度学习在时间序列预测领域的创新不仅体现在transformer结构的改进上,还包括跨模态数据合成、直接应用的LLM以及新的正则化技术。这些进展为时间序列分析提供了更强大的工具,推动了该领域的进一步发展。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...