引言

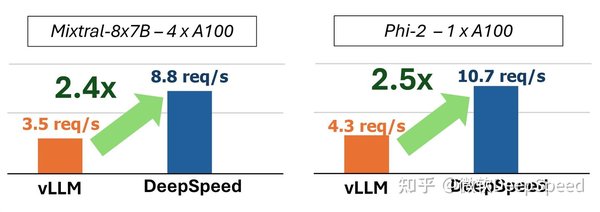

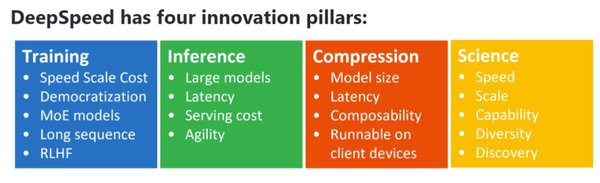

在当今的大模型推理领域,如何高效地利用硬件资源并降低成本是一个亟待解决的问题。微软研究院开源的DeepSpeed-FastGen工具通过创新的动态序列批处理技术和异构内存管理系统,显著提升了大模型推理效率,降低了硬件成本。本文将深入探讨这一工具的核心技术及其在实际应用中的表现。

动态序列批处理技术

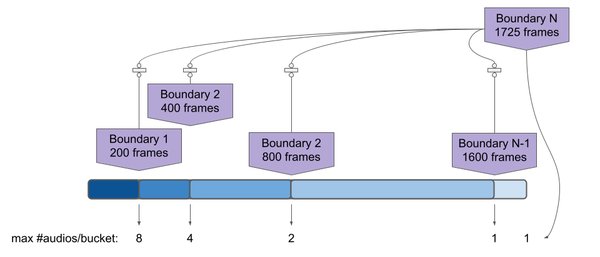

DeepSpeed-FastGen的核心技术之一是动态序列批处理技术。这一技术能够根据输入序列的长度和复杂度,动态调整批处理的大小,从而最大化硬件资源的利用率。在实际应用中,这一技术使得在NVIDIA A100上实现130B模型的流畅运行成为可能,单节点可同时处理120个并发会话。

异构内存管理系统

异构内存管理系统是DeepSpeed-FastGen的另一个重要组成部分。该系统能够智能地管理不同类型的存储资源,包括高速缓存、主存和持久化存储,从而优化数据访问速度和存储成本。通过这一系统,DeepSpeed-FastGen在处理大规模模型时,能够显著减少内存占用,提升整体性能。

实际应用场景

DeepSpeed-FastGen在多个实际应用场景中展示了其广泛的应用潜力。在电商领域,该工具能够高效处理大规模的用户请求,提升用户体验。在医疗领域,DeepSpeed-FastGen能够快速分析大量医疗数据,辅助医生做出更准确的诊断。在金融领域,该工具能够实时处理复杂的金融模型,提升交易效率。

开源生态与未来发展

DeepSpeed-FastGen的开源生态正在快速成长,HuggingFace已集成该工具的适配器。未来,随着更多开发者和企业的加入,这一工具有望在更多领域得到广泛应用,进一步推动大模型推理技术的发展。

结语

DeepSpeed-FastGen通过创新的动态序列批处理技术和异构内存管理系统,显著提升了大模型推理效率,降低了硬件成本。在实际应用中,该工具展示了其广泛的应用潜力,为电商、医疗和金融等领域带来了显著的效益。随着开源生态的快速成长,DeepSpeed-FastGen有望在更多领域发挥其重要作用。