Vision Transformers (ViT):计算机视觉的新范式

近年来,Transformer架构在自然语言处理(NLP)领域取得了巨大成功,而Vision Transformers (ViT) 的提出则标志着这一革命性技术正式进军计算机视觉领域。ViT通过将图像分割为Patch序列,并利用自注意力机制进行全局处理,打破了传统卷积神经网络(CNN)在图像处理中的主导地位。

ViT的核心技术:自注意力机制与Patch处理

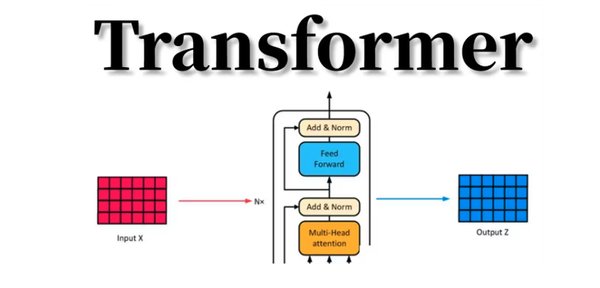

ViT的核心在于自注意力机制,这一机制允许模型在图像的不同部分之间建立关联,从而捕捉全局信息。与传统CNN的局部特征提取不同,ViT将图像视为一系列非重叠的Patch,每个Patch被线性嵌入为向量,并通过Transformer编码器进行处理。这种方法不仅减少了计算复杂度,还使得模型能够处理任意尺寸的图像。

自注意力机制的优势

自注意力机制通过计算输入序列中每个元素与其他元素的关联权重,使得模型能够动态地关注图像中的重要区域。这种机制在处理复杂视觉任务时表现出色,尤其是在需要捕捉长距离依赖关系的场景中。

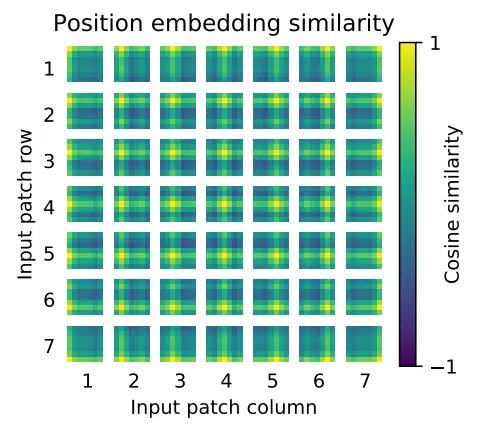

Patch处理与位置嵌入

ViT将图像分割为16×16的Patch,并将每个Patch转换为向量嵌入。为了保留图像的空间信息,ViT引入了位置嵌入,确保模型能够理解Patch之间的相对位置关系。这种设计使得ViT在图像分类任务中表现出色,甚至超越了传统CNN。

ViT的性能表现与挑战

ViT在多个图像分类数据集上取得了显著的成绩。例如,在JFT-300M数据集上预训练的ViT模型,在ImageNet等基准测试中超越了ResNet等传统CNN模型。然而,ViT的成功依赖于大规模的训练数据,这在某些应用中可能成为限制因素。

数据依赖性与计算效率

ViT需要大量的训练数据才能发挥其优势。在较小规模的数据集上,ViT的表现可能不如CNN,因为后者通过卷积层引入了更强的归纳偏差。此外,ViT的训练计算成本较高,尽管其在推理阶段表现出较高的效率。

未来发展方向

尽管ViT在图像分类任务中表现出色,但其在目标检测和图像分割等任务中的应用仍需进一步研究。未来的研究可能会聚焦于开发更轻量级的ViT架构,以及探索自监督预训练等方法,以降低对大规模数据的依赖。

结论

Vision Transformers (ViT) 代表了计算机视觉领域的一次重大突破,其通过自注意力机制和Patch处理技术,为图像处理提供了新的思路。尽管面临数据依赖性和计算效率等挑战,ViT的潜力不容忽视。随着技术的不断进步,ViT有望在更多视觉任务中发挥重要作用,推动人工智能领域的进一步发展。