在深度学习的广阔领域中,注意力机制已经成为处理序列数据的重要工具。其中,交叉注意力机制(Cross Attention)作为一种跨序列信息处理的核心技术,正在越来越多的研究和应用中展现出其独特的价值。

自注意力与交叉注意力的对比

自注意力机制(Self-Attention)和交叉注意力机制是Transformer模型中的两种关键注意力机制。自注意力机制主要用于处理单一序列内部的依赖关系,通过计算序列中每个元素之间的注意力分数,捕捉长距离依赖关系。例如,在语言建模任务中,自注意力机制可以帮助模型理解句子中单词之间的上下文关系。

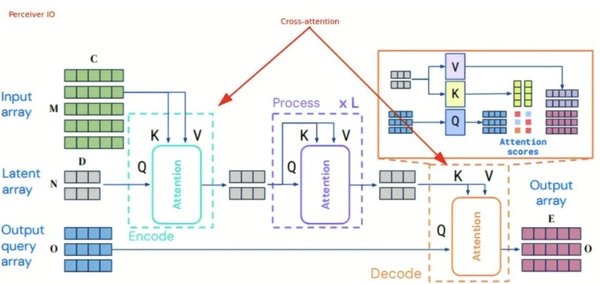

相比之下,交叉注意力机制则专注于处理两个不同序列之间的关系。它的核心思想是将一个序列的元素作为查询(Query),而另一个序列的元素作为键(Key)和值(Value),从而计算两个序列之间的注意力分数。这种机制使得模型能够在处理一个序列时参考另一个序列的信息,例如在机器翻译任务中,解码器可以通过交叉注意力机制关注编码器处理后的源语言文本,从而生成目标语言文本。

交叉注意力机制的应用场景

交叉注意力机制在许多复杂的序列到序列任务中发挥着重要作用。以下是一些典型的应用场景:

-

机器翻译:在Transformer模型的解码器中,交叉注意力机制使得解码器能够同时关注源语言文本和已经生成的目标语言文本,从而提高翻译的准确性。

-

图像字幕生成:通过将图像特征与自然语言描述相关联,交叉注意力机制可以帮助模型生成更符合图像内容的字幕。

-

问答系统:在问答任务中,交叉注意力机制可以将问题文本与知识库或文档中的信息进行关联,从而找到更准确的答案。

交叉注意力机制在解耦表征学习中的创新应用

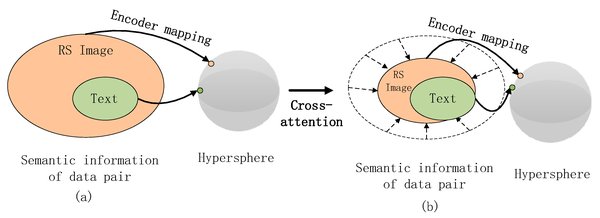

在最新的研究中,交叉注意力机制与扩散模型的结合为解耦表征学习(Disentangled Representation Learning)提供了新的思路。例如,NeurIPS 2024的一篇论文《利用基于交叉注意力的扩散模型作为解耦的归纳偏置》提出了一个名为EncDiff的新框架。该框架通过扩散模型与交叉注意力机制的结合,显著提升了机器学习的可解释性、泛化能力和鲁棒性。

研究显示,EncDiff在无需额外正则化项的情况下,能够实现卓越的解耦性能。这一成果不仅展示了扩散过程和交叉注意力机制在解耦学习中的重要作用,也为未来的研究提供了新的方向。

结语

交叉注意力机制作为深度学习中的一项重要技术,正在为处理跨序列数据提供强大的支持。无论是传统的机器翻译任务,还是新兴的解耦表征学习,交叉注意力机制都展现出了其独特的优势。随着研究的深入,我们相信这一机制将在更多领域发挥更大的作用,推动人工智能技术的进一步发展。