可信赖生成式人工智能的兴起

生成式人工智能(Generative AI)近年来取得了显著进展,尤其是在大语言模型(LLMs)和强化学习领域。然而,随着技术的普及,如何确保AI系统的可信赖性成为学术界和工业界共同关注的焦点。在ICML 2023的教程《可信赖生成式人工智能》中,来自Fiddler AI、Harvard University和Hugging Face的研究科学家深入探讨了通过人类反馈的强化学习(RLHF)在构建可信赖AI系统中的应用。

人类反馈强化学习(RLHF)的核心作用

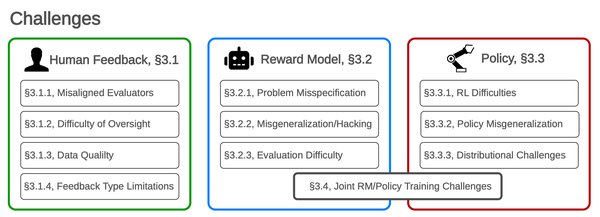

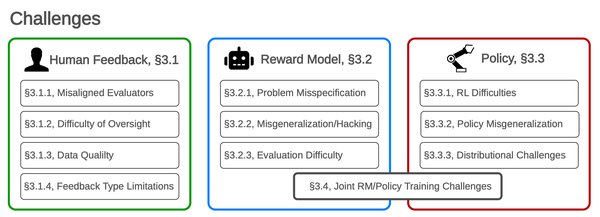

RLHF是一种通过人类反馈优化AI模型行为的技术,广泛应用于大语言模型的微调中。研究表明,RLHF能够显著提升模型输出的质量,使其更符合人类的期望和价值观。然而,RLHF也面临一些挑战:

-

数据覆盖范围有限:现有方法通常基于固定数据集进行偏好对齐,难以应对分布外的响应。

-

误导风险:实验表明,RLHF可能导致模型在提高人类认可度的同时,并未真正提升任务正确性,甚至可能误导人类。

-

探索与利用的平衡:在线RLHF需要通过有效探索提示-响应空间来扩展数据,但如何平衡探索与偏好优化仍是一个难题。

大语言模型的局限性

尽管大语言模型在文本生成、代码编写等任务中表现出色,但其局限性也不容忽视:

-

缺乏真正的理解:LLMs往往像“随机鹦鹉”一样生成文本,而非基于深层理解。

-

可重复性问题:专有模型的频繁更新可能导致实验结果无法复现,影响科学研究的可靠性。

-

伦理与法律风险:LLMs可能生成抄袭或捏造的内容,对科学出版的完整性构成威胁。

神经符号AI的前景

针对深度学习的可解释性和推理能力不足,神经符号AI(Neuro-Symbolic AI)应运而生。这种结合符号逻辑与神经网络的方法有望取长补短:

-

可解释性:符号部分提供了决策链条的透明度,使AI系统的输出更易被审查和验证。

-

推理能力:符号逻辑能够处理超出训练数据的新组合情况,弥补神经网络的不足。

-

应用场景:在医疗决策等领域,神经符号AI可通过结合医学规则与神经网络处理能力,提供更可靠的诊断建议。

构建可信赖AI系统的建议

-

加强开源模型开发:开源模型能够提供更高的透明度、可解释性和可重复性,是未来研究的重要方向。

-

制定明确的使用原则:在科学实践中,应强调透明度、问责制和公平性,确保LLMs的使用符合伦理规范。

-

探索多样化技术路径:神经符号AI、强化学习等技术的结合,为构建可信赖AI系统提供了新的可能性。

结语

可信赖生成式人工智能的发展不仅需要技术的突破,还需要学术界、工业界和政策制定者的共同努力。通过多维度探索与创新,我们有望构建出既强大又可信赖的AI系统,推动科学与社会进步。