INT8量化技术在DeepSeek模型部署中的应用

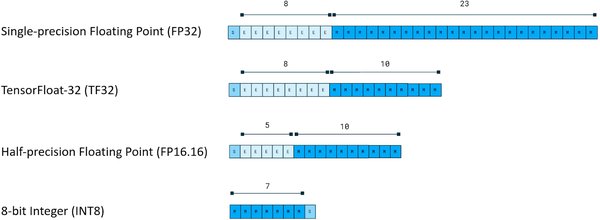

随着DeepSeek大模型的爆火,其部署和推理成本成为业界关注的焦点。INT8量化技术作为一种高效的模型压缩方法,在DeepSeek模型的部署中发挥了重要作用。通过将模型参数从FP32或FP16降低到INT8,可以显著减少模型的内存占用和计算量,从而提高推理速度和降低硬件需求。

在DeepSeek-R1模型的部署中,INT8量化技术被广泛应用于分块量化和通道量化两种方式。分块量化通过将模型参数划分为多个块进行量化,而通道量化则针对不同通道进行独立量化。这两种方法在降低模型精度的同时,保持了较高的推理性能,使得DeepSeek模型能够在资源受限的端侧设备上运行。

国产AI芯片适配满血版DeepSeek的挑战

尽管INT8量化技术为DeepSeek模型的部署提供了便利,但国产AI芯片在适配满血版DeepSeek模型时仍面临诸多挑战。满血版DeepSeek模型参数高达671B,即使是INT8精度的模型也需671G的存储空间,这对硬件提出了极高的要求。

国产AI芯片在多机互联方面的不足成为适配满血版DeepSeek的主要瓶颈。Nvidia的NV Link技术在多机互联中表现出色,而国产芯片多依赖InfiniBand或高速以太网RoCE,这些方案的通信延迟较大,影响了最终部署效果。此外,国产AI芯片不原生支持FP8数据类型,进一步限制了其在满血版DeepSeek部署中的表现。

FP8计算能力的未来展望

随着AI模型的不断增大,FP8计算能力将成为未来AI发展的关键。FP8作为一种新型的数据类型,能够在保持较高精度的同时,显著降低计算和存储需求。目前,全球领先的AI芯片公司如英伟达和AMD已在其最新产品中支持FP8,而国产AI芯片在这一领域仍有待突破。

FP8的普及将为AI模型的训练和推理带来革命性的变化。例如,由65536块英伟达H200组成的集群在FP8计算能力下,峰值性能可达万亿亿次级浮点运算,这将极大提升AI模型的训练效率和推理速度。对于国产AI芯片而言,尽快支持FP8数据类型将是其在国际竞争中取得优势的关键。

结论

INT8量化技术在DeepSeek大模型的部署中发挥了重要作用,但国产AI芯片在适配满血版DeepSeek时仍面临多机互联和FP8支持等挑战。未来,随着FP8计算能力的普及,AI模型的训练和推理效率将得到显著提升。国产AI芯片企业需加快技术创新,突破技术瓶颈,以在全球AI竞争中占据有利地位。

DeepSeek的火爆不仅推动了AI模型的发展,也为AI基础设施和算力硬件公司带来了巨大的市场机遇。华尔街已意识到这一点,预计2025年半导体行业将迎来新的发展高峰。对于国产AI芯片企业而言,抓住这一机遇,提升技术实力,将是其未来发展的关键。