DeepSeek与Transformer架构的协同创新

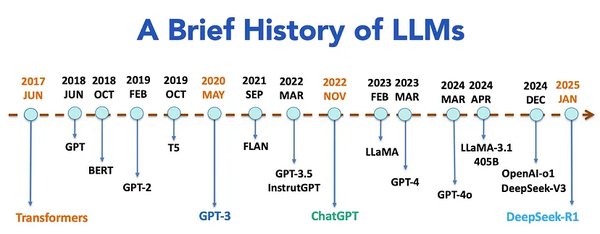

近年来,人工智能领域取得了显著进展,尤其是大型语言模型(LLMs)的崛起。尽管DeepSeek仍基于谷歌提出的Transformer架构,未实现颠覆性基础理论创新,但通过系统级协同创新,在资源受限情况下实现了对标一流大语言模型的性能。本文将深入探讨DeepSeek如何通过优化Transformer架构,实现高效能AI的突破。

Transformer架构的基石作用

Transformer架构自2017年提出以来,彻底革新了自然语言处理(NLP)领域。其核心创新在于自注意力机制(Self-Attention),使模型能够动态关注输入的相关部分,从而提高全局上下文理解。DeepSeek大模型正是基于这一架构,通过多头潜在注意力(MLA)机制和混合专家架构(MoE),进一步优化了Transformer的性能。

多头潜在注意力(MLA)机制

在处理长文本时,传统注意力机制常常遭遇困境。DeepSeek的多头潜在注意力(MLA)机制通过低秩联合压缩机制,将Key-Value矩阵压缩为低维潜在向量,大大减少了内存占用。例如,在处理一篇长达数万字的学术论文时,MLA机制能够轻松应对,快速准确地提取出论文的核心观点、研究方法和重要结论等关键信息。

混合专家架构(MoE)的效率先锋

DeepSeek创新性地采用了混合专家架构(MoE),这一架构堪称模型的效率先锋。MoE架构的原理就像是组建了一个专家团队,团队中的每个专家都在特定领域拥有深厚的专业知识和技能,擅长处理某一类特定的任务。当模型接收到任务指令时,它并不会让所有模块一拥而上地处理,而是通过巧妙的路由机制,精准地判断任务的性质和特点,然后将任务分配给最能胜任的专家。

以DeepSeek-V3为例,它拥有高达6710亿的总参数,然而在处理每个token时,仅有370亿参数被激活。这种“按需激活”的策略,就像一个智能的资源管理器,大大减少了不必要的计算量,让模型在处理复杂任务时能够轻装上阵,既快速又灵活。

强化学习的推理能力提升

DeepSeek-R1-Zero通过强化学习(RL)增强其推理能力,完全消除了监督微调(SFT)阶段,直接从名为DeepSeek-V3-Base的预训练模型开始。它采用了一种基于规则的强化学习方法,称为组相对策略优化(GRPO),根据预定义规则计算奖励,使训练过程更简单且更具可扩展性。

未来展望:挑战与机遇

尽管DeepSeek在优化Transformer架构方面取得了显著进展,但仍面临诸多挑战。例如,模型的“黑箱化”特性引发治理难题,尽管无锡市政务系统通过“双结果显示”机制提升透明度,但模型决策逻辑的不可解释性仍导致30%用户对AI建议持怀疑态度。

未来,DeepSeek研发团队正探索量子计算与动态数学建模的融合。通过将复杂问题分解为量子比特态空间,模型推理速度有望再提升1000倍。在药物研发领域,这种架构可使分子模拟效率提升至传统方法的10^6倍,或将新药研发周期从12年缩短至3年以内。

结论

DeepSeek通过系统级协同创新,在资源受限情况下实现了对标一流大语言模型的性能,尽管其模型仍基于谷歌提出的Transformer架构,未实现颠覆性基础理论创新。通过优化Transformer架构,DeepSeek不仅在算法效率、应用场景拓展上实现跃升,更推动AI技术从“工具辅助”向“认知协同”的范式转变。未来,DeepSeek将继续探索量子化推理架构,构建人机共生生态,实现技术普惠与风险防控的平衡。