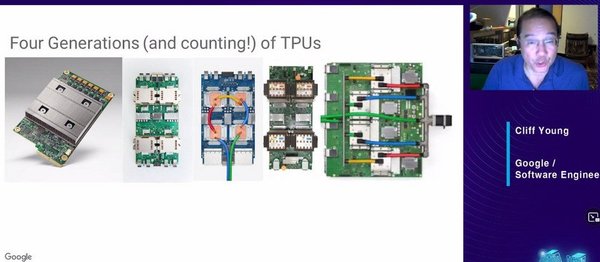

TPU:AI时代的计算核心

在AI技术的快速发展中,TPU(Tensor Processing Unit)作为专为深度学习优化的处理器,已经成为AI基础设施的核心组件之一。TPU的诞生源于对高效计算的需求,尤其是在训练和推理大规模AI模型时,传统CPU和GPU的性能瓶颈逐渐显现。TPU通过高度优化的硬件架构,显著提升了AI任务的效率,成为推动AI技术落地的重要力量。

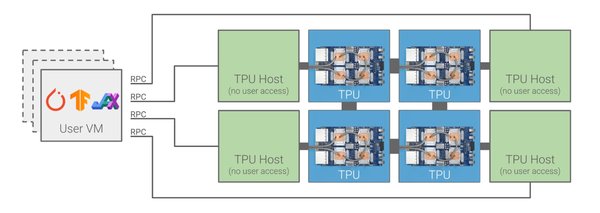

云平台与TPU的协同发展

云平台作为AI应用的重要载体,正在与TPU等AI芯片深度融合。例如,Google Cloud通过TPU提供了强大的AI计算能力,支持从模型训练到推理的全流程需求。与此同时,云平台也在探索将AI能力扩展到本地和边缘计算场景。Google Distributed Cloud等解决方案,允许企业在本地数据中心部署云服务,同时利用TPU等硬件加速AI任务。这种模式特别适用于对数据隐私和低延迟要求较高的行业,如金融、能源和政府领域。

AI芯片市场的竞争与创新

AI芯片市场的竞争日益激烈,除了TPU,NVIDIA、Intel、AMD等公司也在不断推出新的硬件解决方案。例如,Intel通过一系列AI产品布局,Tenstorrent与Rapidus合作开发新技术,而RISC-V的开源指令集架构也为AI芯片设计提供了新的可能性。这种多元化的竞争格局不仅推动了技术进步,也为企业提供了更多选择。

TPU与开源生态的协同

开源软件在AI生态中扮演着重要角色,而TPU与开源框架(如TensorFlow)的深度集成,进一步降低了AI开发的门槛。通过开源社区的支持,开发者可以更高效地利用TPU进行模型训练和部署,加速AI应用的落地。

数据提供商:AI基础设施的关键一环

在AI时代,数据是训练模型的基础,而数据提供商则为AI应用提供了不可或缺的资源。无论是结构化数据还是非结构化数据,高质量的数据集都是AI模型性能的关键。TPU等硬件的高效计算能力,使得处理海量数据成为可能,从而推动了AI技术的进一步发展。

总结

TPU作为AI基础设施的重要组成部分,与云平台、开源软件和数据提供商共同构成了AI生态的基石。在AI技术不断发展的今天,TPU等硬件将继续推动计算效率的提升,为AI应用的广泛落地提供支持。与此同时,AI芯片市场的竞争与创新也将为行业带来更多可能性,进一步加速AI技术的普及与深化。