大模型的定义与演变

大模型(Large Language Models, LLMs)是人工智能领域的核心技术之一,旨在处理、理解和生成类似人类的语言。它们通过从海量数据中学习语言模式和结构,推动了翻译、摘要、对话系统和内容生成等应用的发展。

Transformer架构的诞生

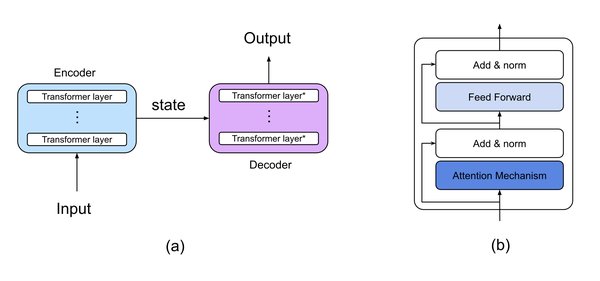

2017年,Vaswani等人提出的Transformer架构彻底改变了自然语言处理(NLP)领域。Transformer通过自注意力机制解决了早期模型(如RNN和LSTM)在长程依赖性和计算效率上的局限性,为现代大模型奠定了基础。

GPT-3的突破

2020年,OpenAI发布的GPT-3凭借1750亿参数展示了规模在AI中的变革力量。GPT-3在少样本和零样本学习任务中表现出色,开启了生成式AI的新时代。

大模型的技术创新

多模态模型的崛起

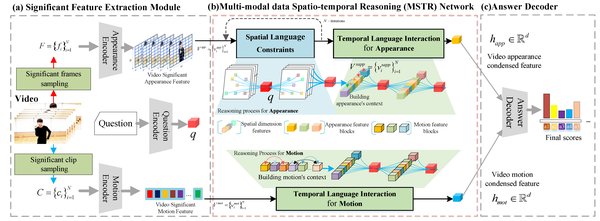

2023年至2024年,多模态大型语言模型(MLLMs)如GPT-4V和GPT-4o将文本、图像、音频和视频整合到统一系统中,实现了更丰富的交互和复杂问题解决能力。

推理模型的进阶

2024年,OpenAI推出的o1系列推理模型通过长链思维(Long CoT)和推理时计算控制,显著提升了复杂任务(如数学和编程)的表现。

低成本化与普及化

DeepSeek-R1的突破

2025年初,DeepSeek推出的R1系列模型通过专家混合架构(MoE)和强化学习技术,实现了高性能推理的极低成本化。例如,DeepSeek-R1的训练成本仅为OpenAI同类模型的1/30,推动了AI的普及化。

开源模型的贡献

开源模型如LLaMA和Mistral 7B通过微调和知识蒸馏技术,进一步降低了AI研发成本。例如,斯坦福大学的S1模型仅用20美元的训练成本便实现了与前沿推理模型相当的性能。

大模型的未来展望

能力密度的提升

大模型的能力密度正随时间呈指数级增强。例如,DeepSeek-V3的激活参数仅为同类模型的1/10,而推理成本降低了40%。

普及化与行业应用

随着成本的降低和技术的成熟,大模型将逐步“飞入寻常百姓家”,推动医疗、教育、创意产业等领域的智能化变革。

结论

从Transformer架构的引入到DeepSeek-R1的突破,大模型的演变标志着人工智能领域的革命性进步。未来,随着技术的不断优化和成本的持续降低,大模型将在更多场景中发挥重要作用,推动AI的普及化和应用创新。