英伟达的CUDA与cuDNN:AI计算的基石

在AI技术的飞速发展中,英伟达凭借其CUDA(Compute Unified Device Architecture)和cuDNN(CUDA Deep Neural Network library)成为了AI计算生态的核心驱动力。这两项技术不仅是英伟达GPU加速计算的基础,也是深度学习与AI应用得以快速发展的关键。

CUDA:并行计算的革命

CUDA是英伟达于2007年推出的并行计算平台和编程模型。它通过提供一个扩展标准编程语言的抽象层,简化了GPU编程,使得开发者能够将英伟达的GPU用于广泛的计算任务,包括科学研究、工程、金融建模以及最重要的人工智能领域。

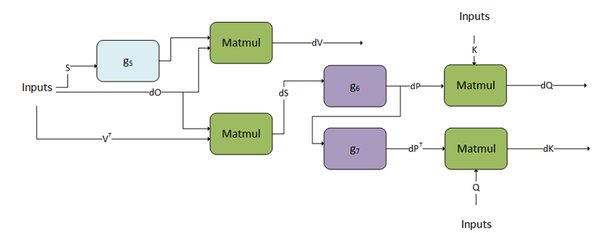

CUDA的核心优势在于其并行计算能力。通过将任务分解为多个小任务并在GPU的数千个核心上并行执行,CUDA能够显著加速计算过程。这种并行计算的能力在深度学习中尤为重要,因为神经网络的训练通常涉及大量的矩阵运算,而这些运算非常适合在GPU上并行处理。

cuDNN:深度学习的加速引擎

cuDNN是英伟达为深度学习开发者提供的高性能库,专门用于加速卷积神经网络(CNN)的训练和推理。cuDNN提供了高度优化的算法实现,能够在英伟达的GPU上实现极致的性能。

cuDNN的主要功能包括:

– 卷积操作的高效实现

– 池化操作的优化

– 激活函数的高效计算

– 归一化操作的加速

通过使用cuDNN,开发者可以轻松地将深度学习模型的训练和推理速度提升数倍,从而大大缩短了模型开发的时间。

全栈加速能力:英伟达的竞争优势

英伟达的全栈加速能力是其AI计算生态的核心竞争力。全栈加速不仅包括硬件层面的GPU加速,还包括软件层面的CUDA和cuDNN优化,以及更上层的AI框架和工具链的支持。

英伟达的全栈加速能力体现在以下几个方面:

1. 硬件性能:英伟达的GPU在AI计算中表现出色,尤其是在深度学习和大规模并行计算任务中。

2. 软件生态:CUDA和cuDNN为开发者提供了强大的工具和库,使得AI模型的开发和部署更加高效。

3. 全栈解决方案:英伟达推出了如DGX系统等全栈解决方案,集成了硬件、软件和优化工具,为企业提供“开箱即用”的AI解决方案。

未来展望:AI基础设施的潜力

随着AI技术的不断发展,英伟达的CUDA和cuDNN将在未来AI基础设施中发挥更加重要的作用。黄仁勋在最近的采访中预测,英伟达将拥有5万名员工和1亿个AI智能体,这表明英伟达在AI领域的布局将继续扩大。

未来,英伟达的全栈加速能力将进一步推动AI技术的普及和应用,尤其是在以下几个方面:

– AI推理的爆发性增长:随着AI模型在推理任务中的应用越来越广泛,英伟达的GPU和cuDNN将继续发挥关键作用。

– AI基础设施投资:英伟达的全栈解决方案将成为AI基础设施投资的重要组成部分,推动AI技术的规模化应用。

– AI模型的互动和进化:英伟达的CUDA和cuDNN将支持更复杂的AI模型互动和进化,推动AI技术的进一步发展。

结语

英伟达的CUDA和cuDNN不仅是AI计算生态的核心驱动力,也是深度学习与AI技术得以快速发展的关键。通过全栈加速能力,英伟达将继续引领AI技术的发展,推动AI技术在各个领域的广泛应用。未来,随着AI基础设施的不断完善,英伟达的CUDA和cuDNN将在AI计算生态中发挥更加重要的作用。