引言

在人工智能飞速发展的今天,模型架构的创新与优化始终是推动技术进步的核心力量。混合专家模型(Mixture of Experts, MoE)凭借其独特的设计理念和卓越的性能表现,在大模型领域崭露头角。DeepSeek作为这一技术的领军者,通过动态专家路由优化和创新的架构设计,为AI领域带来了革命性的突破。

MoE架构:专家协同的智慧矩阵

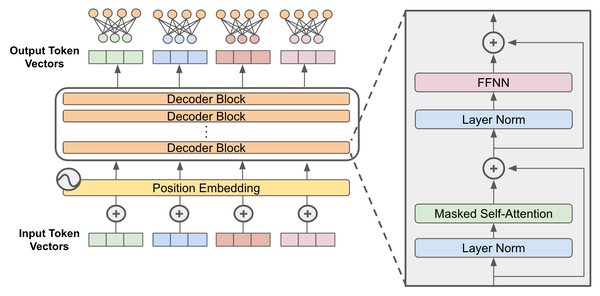

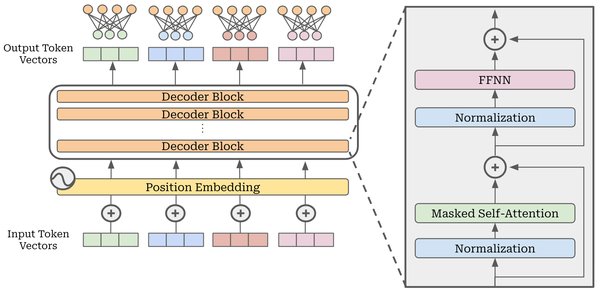

MoE架构的设计灵感源于对人类分工协作模式的深刻洞察。它由多个专门处理特定子任务的“专家”模型组成,宛如一个专家智囊团。每个专家都经过精心训练,在其擅长的领域内表现出色。例如,在自然语言处理任务中,有的专家擅长语法解析,有的则精通语义理解。

核心组件

- 专家网络(Expert Network):负责处理特定子任务的前馈网络。

- 门控网络(Gating Network):根据输入数据特征,为每个专家计算适配分数,选择最适合的专家组合。

- 选择器(Selector):根据专家权重,选择Top1或TopK专家进行结果融合。

DeepSeek的技术突破

DeepSeek在MoE架构的基础上,通过多项技术创新,显著提升了模型的性能和效率。

动态专家路由优化

动态专家路由是MoE架构实现高效性的关键机制。它打破了传统模型“一刀切”的模式,仅激活与当前任务相关的专家,大大减少了不必要的计算开销。例如,在处理包含数学计算和文本分析的复杂问题时,门控网络会将数学部分路由到擅长数学运算的专家,而将文本部分分配给精通语义理解的专家。

创新技术

- 多头潜注意力(MLA):通过低秩键值联合压缩技术,显著减少了KV缓存的大小,提高了计算效率。

- 无辅助损耗负载均衡:采用细粒度专家+通才专家的思路,通过动态调整偏差项,确保负载均衡,无需辅助损失。

- FP8训练框架:采用FP8混合精度训练,加速训练并降低GPU内存使用。

产业应用与落地

DeepSeek的MoE架构不仅在技术上取得了突破,还在多个产业场景中实现了广泛应用。

典型案例

- 政务智能化:深圳宝安区政务大模型接入“腾讯混元+DeepSeek”双核驱动,赋能31个业务场景智能化升级。

- 智慧办公:上海医药联合腾讯云开发智能体,3万多名员工进入智慧办公新时代,药学知识库与DeepSeek大模型结合,助力提供精准药学建议。

- 企业应用:腾讯会议、腾讯文档等企业应用接入DeepSeek,提升产品能力和用户体验。

未来展望

随着技术的不断发展,MoE架构将在更多领域发挥重要作用。例如,在医疗领域,帮助医生快速准确地分析医学影像、诊断疾病;在自动驾驶领域,实时处理车辆传感器数据,做出精准决策。DeepSeek的成果也为国产AI芯片的发展提供了启示,推动中国在全球竞争中占据有利地位。

结语

混合专家模型(MoE)以其独特的架构和DeepSeek的技术突破,正在成为AI时代的重要引擎。它不仅提升了计算效率和资源利用率,还在多个产业场景中实现了广泛应用。未来,随着技术的不断进步,MoE架构将为人工智能的发展注入新的活力,推动大模型技术迈向更高的台阶。