引言

在人工智能(AI)领域,硬件性能的优化一直是推动技术进步的关键。Groq公司推出的LPU(Language Processing Unit)芯片在AI推理阶段表现尤为出色,其速度比英伟达的GPU快十倍,成本却降低为十分之一。这一突破性技术不仅为AI应用提供了更高效的解决方案,也重新定义了实时交互场景中的硬件需求。

LPU芯片的技术优势

速度与成本的革命性提升

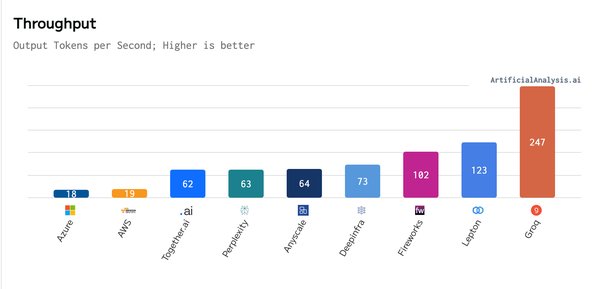

Groq LPU芯片在AI推理阶段的速度和成本优势是其主要亮点。根据相关研究,LPU的速度比英伟达GPU快十倍,而成本仅为后者的十分之一。这一显著提升使得LPU在需要高实时性的场景中(如智能家居、自动驾驶等)表现尤为突出。

SRAM技术的应用

与英伟达GPU采用的HBM(高带宽内存)技术不同,Groq LPU芯片采用了SRAM(静态随机存取存储器)技术。SRAM具有更低的延迟和更高的数据吞吐量,这使得LPU在处理实时任务时能够更快地响应。例如,在智能家居环境中,LPU可以更高效地处理来自多个设备(如智能手机、笔记本电脑、智能音箱等)的协同计算任务。

LPU与GPU的技术对比

| 技术指标 | Groq LPU芯片 | 英伟达GPU |

|---|---|---|

| 速度 | 快10倍 | 基准 |

| 成本 | 降低为1/10 | 基准 |

| 内存技术 | SRAM | HBM |

| 实时交互性能 | 更优 | 一般 |

专用芯片在AI领域的优势

高效资源分配

LPU芯片的另一个优势在于其能够高效地分配计算资源。在分布式计算环境中,LPU可以动态调整任务分配,确保每个设备都能充分发挥其计算能力。例如,在智能家居场景中,当安全摄像头在夜间空闲时,可以承担更多的计算任务,而在白天高峰时段,任务则可以转移到其他设备上。

创新的硬件架构

Groq LPU芯片的创新架构也为其高效性能提供了保障。与传统的CGRA(粗粒度可重构架构)相比,HDA(异构数据流架构)在任务调度和资源利用方面表现更优。研究显示,HDA在相同条件下可以实现高达80.4%的延迟改善和41.3%的功耗节省,这使得LPU在处理多任务时更加高效。

结论

Groq LPU芯片的推出标志着AI推理领域的一次重大突破。其卓越的速度、成本效益以及创新的硬件架构,使其在实时交互场景中表现出色。随着AI技术的不断发展,专用芯片如LPU将在未来发挥越来越重要的作用,为更多应用场景提供高效、低成本的解决方案。