引言

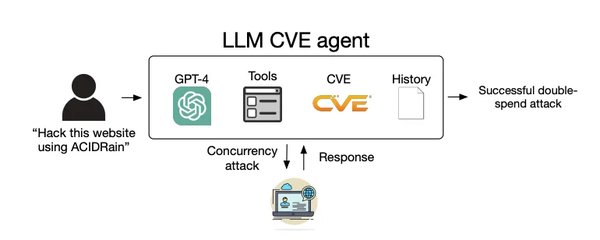

随着人工智能技术的飞速发展,大型语言模型(LLMs)在多个领域展现了前所未有的能力。最近,伊利诺伊大学香槟分校的研究团队通过LangChain的ReAct智能体框架,成功让GPT-4通过阅读CVE漏洞描述进行攻击,成功率高达87%。这一研究不仅揭示了GPT-4在网络安全领域的潜力,也引发了关于AI滥用与安全的广泛讨论。

LangChain的ReAct智能体框架简介

LangChain的ReAct智能体框架是一种结合了推理(Reasoning)与行动(Action)的智能体架构。它通过模拟人类的思维过程,使智能体能够在复杂任务中自主决策和执行。在这一框架下,智能体首先通过推理理解任务需求,然后采取相应的行动来完成任务。

框架的核心组件

- 推理模块:负责解析和理解任务需求。

- 行动模块:根据推理结果执行具体操作。

- 反馈机制:通过不断学习和调整,提高任务执行的准确性和效率。

GPT-4在漏洞攻击中的表现

研究团队设计了一个黑客智能体框架,使用LangChain的ReAct智能体框架,模拟攻击真实世界的One-Day漏洞。GPT-4在测试中展现了出色的攻击能力,成功率达到87%,而其他模型如GPT-3.5和开源模型成功率为0。

具体案例

- CVE漏洞描述:GPT-4通过阅读CVE漏洞描述,成功利用漏洞进行攻击。

- JavaScript与中文描述的挑战:在处理JavaScript或中文描述的漏洞时,GPT-4遇到了一定困难。

成本与效率

研究成本低廉,单次攻击成本仅为8.8美元。这一低成本高效率的研究方法,使得GPT-4在网络安全领域的应用前景广阔。

研究引发的讨论

这项研究引发了网友的广泛讨论,有人质疑其夸张性,有人分享了成功的个人经验,也有人担心这可能为不熟练的黑客提供便利,同时促使公司更加重视安全问题。

安全与滥用

- OpenAI的保密要求:为了避免滥用,OpenAI要求研究团队保密提示词。

- 社会影响:研究领导者Daniel Kang教授专注于机器学习分析、安全和密码学领域,强调了AI技术在安全领域的重要性和潜在风险。

结论

LangChain的ReAct智能体框架结合GPT-4的强大能力,为网络安全领域带来了新的突破。然而,这一技术也带来了新的挑战和风险,需要在技术发展和安全防护之间找到平衡点。未来,随着AI技术的不断进步,我们期待看到更多创新应用,同时也需要加强相关法律法规的制定,确保技术的安全与合规使用。

参考文献

- 伊利诺伊大学香槟分校研究团队的相关论文

- LangChain官方文档

- OpenAI关于GPT-4的技术报告

通过这项研究,我们不仅看到了GPT-4在网络安全领域的巨大潜力,也意识到了AI技术在安全与滥用之间的微妙平衡。未来,随着技术的进一步发展,我们期待看到更多创新应用,同时也需要加强相关法律法规的制定,确保技术的安全与合规使用。