DeepSeek R1:AI推论的革命性进展

近年来,强化学习(RL)在大型语言模型(LLM)中的应用成为AI领域的热点。Hugging Face组织的DeepSeek R1技术研讨深入探讨了这一方向,揭示了其在推论能力与模型优化方面的突破性进展。DeepSeek R1不仅通过强化学习提升了模型的性能,还引入了创新的GRPO(Group Relative Policy Optimization)算法,为AI模型的训练与优化提供了全新的思路。

强化学习与语言模型的结合

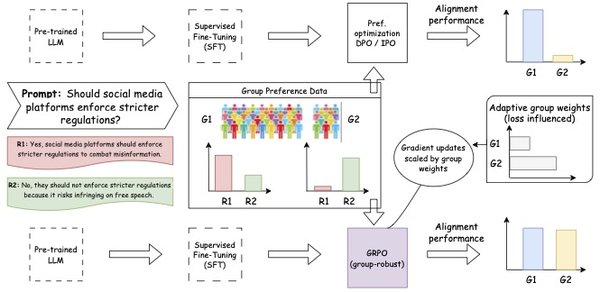

DeepSeek R1的核心在于将强化学习与语言模型相结合,以提升模型的推论能力。传统的语言模型主要依赖于监督学习,而DeepSeek R1通过引入强化学习,使模型能够在试错中不断优化自身。这种方法的优势在于,模型不再仅仅依赖于预先标注的数据,而是通过动态的学习过程,逐步提升其解决问题的能力。

然而,强化学习的应用也带来了新的挑战,例如模型输出的可读性与可用性问题。为了解决这些问题,DeepSeek R1采用了监督微调(SFT)与强化学习的组合策略。通过监督微调,模型能够在保持高质量输出的同时,逐步适应强化学习带来的优化。

GRPO算法:高效优化的关键

DeepSeek R1的另一个亮点是其创新的GRPO算法。与传统的强化学习方法不同,GRPO通过“组内相对优化”的方式,显著提升了训练的稳定性与效率。以下是GRPO算法的核心步骤:

- 组内解答生成:模型针对同一问题生成多个解答,形成解答组。

- 组内评估与评分:通过评估函数对解答组内的各个解答进行评分,确定最优解。

- 模型优化:根据评分结果,调整模型参数,使其更倾向于生成高质量解答。

GRPO的优势在于其灵活性与高效性。它不仅能够适应多种评估函数,还通过组内相对优化的方式,避免了传统强化学习中常见的训练不稳定性问题。

训练过程的四个阶段

DeepSeek R1的训练过程分为四个关键阶段,每个阶段都针对模型的不同能力进行优化:

- 冷启动阶段:通过高质量数据对模型进行微调,建立基础能力。

- 推论强化阶段:通过规则化强化学习,提升模型在数学、逻辑等领域的推论能力。

- 拒绝采样阶段:对模型输出进行质量检查,筛选优质数据用于进一步训练。

- 多样化强化阶段:通过混合评估方法,使模型能够适应多种任务类型。

挑战与未来展望

尽管DeepSeek R1取得了显著进展,但其应用仍面临一些挑战。例如,GRPO算法的计算成本较高,且需要针对不同任务设计合适的评估函数。此外,如何在训练过程中平衡模型的稳定性与多样性,也是一个亟待解决的问题。

未来,随着计算资源的优化与算法的改进,DeepSeek R1有望在更大规模的模型与更复杂的任务中发挥更大的作用。同时,其在多模态模型与实时推理领域的应用潜力也值得期待。

总结

DeepSeek R1通过结合强化学习与创新算法,为语言模型的优化与推论能力提升开辟了新的道路。其独特的训练过程与GRPO算法不仅提高了模型的性能,还为AI领域的研究提供了宝贵的经验。随着技术的不断发展,DeepSeek R1有望成为推动AI模型进化的关键力量。