引言

在生成式AI的快速发展中,如何高效地构建和优化多模型协作系统成为了开发者面临的重要挑战。Anthropic Cookbook提供了一份清晰的实践指南,深入探讨了LLM(大型语言模型)工作流与代理系统的设计与应用。本文将围绕这一主题,结合具体案例,帮助读者更好地理解和应用这些技术。

什么是LLM工作流与代理系统?

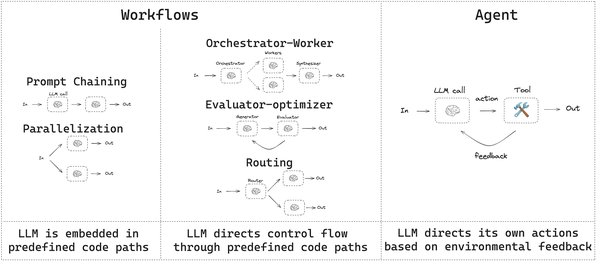

在Anthropic Cookbook中,作者首先定义了“代理系统”这一总称,并将其细分为“工作流”和“代理”两类:

– 工作流:通过预定义的模式将多个LLM协同工作,例如提示链、路由、并行处理等。

– 代理:LLM能够动态地指导自身流程和工具使用,具备更高的自主性。

此外,作者还提出了“增强型LLM”的概念,即通过工具增强的LLM,这一术语为理解LLM的扩展功能提供了新的视角。

五种LLM工作流模式

Anthropic Cookbook详细介绍了五种工作流模式,每种模式都配有实际案例和清晰的命名,便于开发者理解和应用:

-

提示链

例如,生成文档后将其翻译为另一种语言,作为第二个LLM调用。这种模式适用于需要多步骤处理的任务。 -

路由

初始LLM调用决定下一步使用哪个模型或调用。例如,将简单任务分配给Haiku模型,复杂任务分配给Sonnet模型。 -

并行处理

将任务分解并并行运行,例如同时处理多页文档的图像到文本转换,或通过投票机制整合结果。 -

协调器-工作者

协调器触发多个LLM调用,然后将结果整合。例如,从多个来源进行搜索并合并结果。 -

评估器-优化器

一个模型检查另一个模型的工作,并在循环中优化结果。例如,代码生成提示与代码审查评估器循环运行,直到评估器满意为止。

从工作流到代理系统

Anthropic Cookbook为开发者提供了从基础提示到复杂代理系统的升级路径。作者建议,在尝试复杂的代理框架之前,先充分利用直接API访问和简单代码的可能性。只有当工作流模式无法满足需求时,才考虑引入代理系统。

实际案例:代码生成与优化

在Anthropic Cookbook的“评估器-优化器工作流”案例中,作者展示了如何通过循环优化生成代码。例如,修复Python代码中的语法错误:

“`python

修复前

for num in range(2, limit + 1)

修复后

for num in range(2, limit + 1):

“`

这种模式不仅提高了代码质量,还展示了LLM在自动化任务中的强大能力。

结语

Anthropic Cookbook为开发者提供了一份清晰、实用的指南,帮助他们在生成式AI领域构建高效的多模型协作系统。通过理解并应用五种工作流模式,开发者可以逐步从基础提示升级到复杂的代理系统,从而更好地应对实际场景中的挑战。