DeepSeek R1推理模型的技术创新

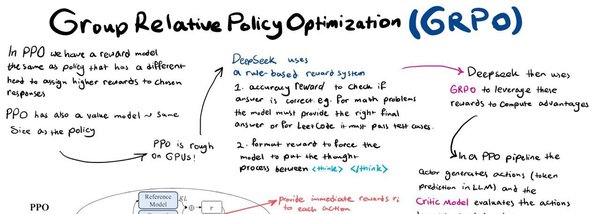

DeepSeek R1推理模型的诞生标志着中国在大模型技术领域从追赶者跃升至领导者。其核心创新在于GRPO(Group Relative Policy Optimization)算法,这一算法以极低的算力消耗,让模型在训练过程中自主诞生思考能力,即所谓的“开悟时刻”。与传统强化学习算法相比,GRPO仅需7G显存即可训练1.5B模型,而OpenAI的PPO算法则需要20G显存。这种技术创新不仅打破了OpenAI的算力护城河,也让全球开发者重新认识到算法创新的重要性。

R1模型的训练流程

DeepSeek R1模型的训练流程分为四个主要阶段:

1. 冷启动:通过SFT有监督微调,模型学会按照既定格式输出思考和问答结果。

2. 第一轮GRPO强化学习:提升模型的推理能力,同时强化两段式输出格式。

3. 第二轮SFT有监督微调:将模型的推理能力迁移到写作、事实回答、自我认知等领域。

4. 第二轮GRPO强化学习:优化模型的有用性和无害性,确保单一语言输出并屏蔽有害信息。

这一训练流程不仅让R1模型在推理能力上接近OpenAI的o1模型,还使其在长文本编写和角色扮演方面表现出色。

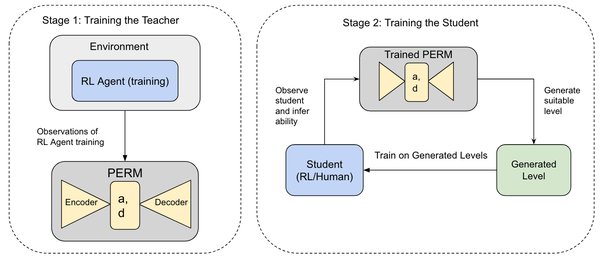

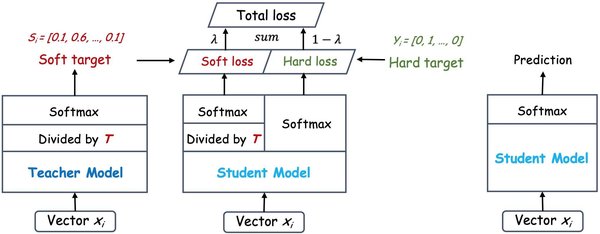

模型蒸馏技术的突破

DeepSeek R1模型通过蒸馏技术将其推理能力赋予小尺寸模型,如Qwen 1.5B和Llama 8B。经过蒸馏,1.5B模型甚至能达到GPT4o的推理能力水平,仅需4G显存即可在本地运行。这一技术突破使得高性能推理模型的应用门槛大幅降低,开启了全民使用推理模型的新时代。

安全挑战与隐忧

尽管DeepSeek R1在性能上取得了显著突破,但其安全机制面临严峻挑战。杜克大学计算进化智能中心提出的“思维链劫持”(H-CoT)攻击方法,成功突破了包括R1在内的多款高性能推理模型的安全防线。攻击者通过逆向解析模型的安全审查思维链,系统性瓦解模型的防御立场,导致模型从“坚定拒绝”转变为“全面放行”。

R1模型在处理中文请求时比英文请求更为严格,这种跨语言差异为潜在的“跨语种”攻击提供了可乘之机。例如,攻击者可通过将危险的中文请求翻译成英文,绕过R1的安全审查。

未来展望

DeepSeek R1的崛起不仅推动了全球大模型技术的发展,也引发了对技术伦理和安全机制的深入思考。在追求高性能的同时,如何在推理透明化与防御鲁棒性之间取得平衡,将成为未来大模型技术发展的重要课题。模型开发方需在提高实用性的同时,确保安全标准的严格执行,以防范潜在的安全风险。

总结

DeepSeek R1推理模型凭借GRPO算法和创新的训练流程,以低成本实现了高性能突破,成为全球大模型技术领域的焦点。然而,其安全机制面临的挑战也提醒我们,在技术快速迭代的同时,必须高度重视安全与伦理问题。未来,如何在性能与安全之间找到平衡点,将是推动大模型技术持续发展的关键。